Este post é a Parte 4 de uma série de 4 partes. Certifique-se de conferir os outros posts da série para um mergulho mais profundo no nosso gerador de planos de negócios com IA.

Parte 1: Como Construímos um Gerador de Planos de Negócios com IA Usando LangGraph & LangChain

Parte 2: Como Otimizamos a Geração de Planos de Negócios com IA: Velocidade vs. Compromissos de Qualidade

Parte 3: Como Criamos 273 Testes Unitários em 3 Dias Sem Escrever Uma Única Linha de Código

Parte 4: Estrutura de Avaliação de IA — Como Construímos um Sistema para Avaliar e Melhorar Planos de Negócios Gerados por IA

Introdução: O Desafio de Avaliar Planos de Negócios com IA

Avaliar conteúdo gerado por IA de forma objetiva é complexo. Diferentemente de saídas estruturadas com respostas claramente certas ou erradas, planos de negócios envolvem pensamento estratégico, avaliações de viabilidade e coerência, tornando a avaliação altamente subjetiva.

Isso trouxe desafios chave:

- Como podemos quantificar o conteúdo de um plano de negócios “bom” versus “ruim”?

- Como podemos garantir que a IA se aperfeiçoe ao longo do tempo?

- Como tornamos a avaliação consistente e imparcial?

Para resolver isso, nós desenvolvemos um framework de pontuação estruturado que nos permite avaliar, iterar e aprimorar planos de negócios gerados por IA. Nossa abordagem combinou múltiplos frameworks de avaliação, cada um adaptado para diferentes seções do plano, garantindo tanto a precisão quanto a profundidade estratégica.

É importante notar que este sistema de avaliação detalhado fazia parte da nossa implementação original, onde cada seção passava por uma avaliação rigorosa e iteração. No entanto, devido a restrições de desempenho, nós simplificamos o processo de avaliação no MVP para priorizar a velocidade de geração. Esse compromisso nos ajudou a implantar mais rapidamente, mantendo o quadro de avaliação como parte da pesquisa contínua para melhorias futuras.

Pesquisas recentes em Avaliação Baseada em LLM confirmaram a eficácia da avaliação de IA estruturada. Estudos como Prometheus 2: Um Modelo de Linguagem de Código Aberto Especializado na Avaliação de Outros Modelos de Linguagem (2024) e a estrutura Evals da OpenAI demonstraram que LLMs podem ser avaliadores confiáveis quando orientados por critérios de pontuação estruturados.

Projetando o Framework de Avaliação

Nós nos inspiramos nos sistemas de avaliação de professores e aplicamos isso a planos de negócios gerados por IA. Isso levou à criação de vários frameworks de avaliação, cada um adaptado a diferentes tipos de seções.

Frameworks de Avaliação por Tipo de Seção

Em vez de usar um método de pontuação único para todos, nós desenvolvemos critérios de pontuação personalizados dependendo do tipo de conteúdo sendo avaliado:

Planejamento Estratégico & Modelo de Negócios

- Avaliado por clareza, alinhamento de metas SMART e viabilidade.

- Exige planos de ação explícitos e definição de metas estruturada.

Pesquisa de Mercado & Análise Competitiva

- Focado em profundidade de pesquisa, diferenciação e validação de dados reais.

- As respostas de IA foram avaliadas com base em realismo de mercado e posicionamento competitivo.

Planejamento Financeiro & Projeções

- Avaliações de suposições financeiras, modelagem de receita e detalhamento de despesas.

- As saídas de IA tiveram que ser quantificadas, internamente consistentes e razoáveis.

Estratégia Operacional & de Execução

- Avaliado com base na viabilidade, mitigação de riscos e rota de execução.

- Requer estrutura clara de equipe e alocação de recursos.

Estratégia de Marketing & Vendas

- Avaliado com base no alinhamento com o público-alvo, potencial de conversão e consistência da marca.

- Os planos de marketing gerados por IA precisavam ser específicos e baseados em dados.

Cada framework atribuiu pesos a diferentes dimensões de avaliação, garantindo que áreas críticas (por exemplo, viabilidade financeira) influenciassem a pontuação geral mais do que áreas menos críticas. Isso está alinhado com descobertas recentes de Prometheus 2: Um Modelo de Linguagem de Código Aberto Especializado em Avaliar Outros Modelos de Linguagem, que enfatizou a necessidade de benchmarks de avaliação detalhados usando LLMs.

Mecanismo De Pontuação De Avaliação

Cada seção foi avaliada de 1 a 5, seguindo um padrão:

Melhoria Iterativa Baseada em IA

Para permitir que a IA se aprimore, nós projetamos um loop de feedback multi-etapas:

Passo 1: Geração de Rascunho

- A IA gera um rascunho inicial baseado na entrada do usuário.

- As seções são estruturadas de acordo com modelos pré-definidos.

Passo 2: Autoavaliação de IA

- A IA revisa seu próprio resultado contra os quadros de avaliação específicos da seção.

- Identifica áreas com dados faltantes, explicações vagas ou alinhamento estratégico fraco.

Etapa 3: Autoaperfeiçoamento de IA

- A IA regenera seções fracas, garantindo melhor alinhamento com os critérios de avaliação.

- Se os dados financeiros ou análise de mercado estiverem insuficientes, a IA ajusta suposições e raciocínios.

Etapa 4: Avaliação Final

- A IA realiza uma segunda passagem de pontuação para validar suas próprias melhorias.

- A versão final é comparada com iterações anteriores para acompanhar o progresso.

Este processo iterativo gerar → avaliar → melhorar está alinhado com as pesquisas mais recentes que mostram que as avaliações baseadas em LLM melhoram ao longo de várias etapas.

Validação Estatística: Realmente Funcionou?

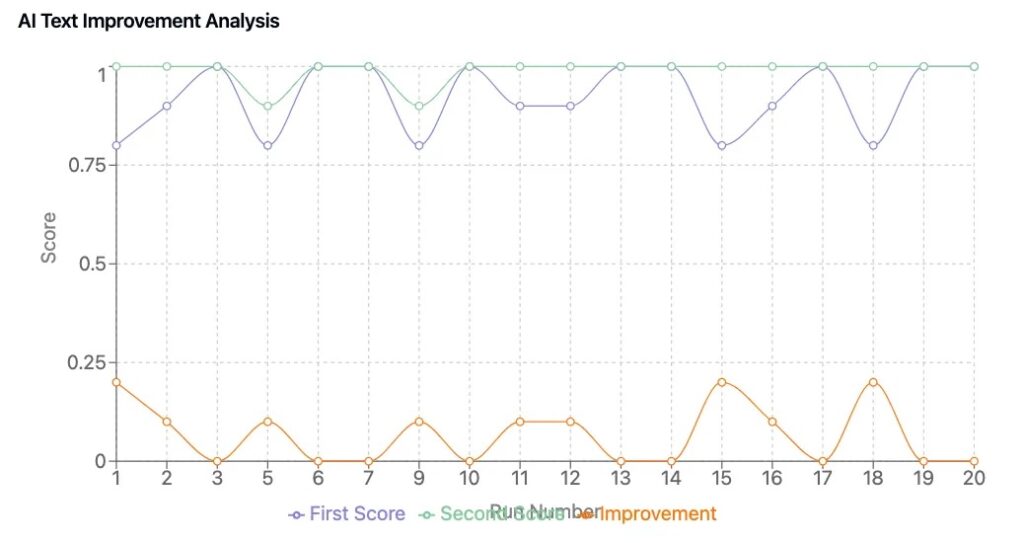

Para confirmar que nosso Framework levou a melhorias tangíveis, realizamos um ciclo de teste de 50 planos, comparando planos de negócios gerados por IA com e sem loops de autoaperfeiçoamento.

Principais Descobertas

- Consistência de Pontuação: Conteúdo gerado por IA pontuou de forma consistente, reduzindo flutuações aleatórias na qualidade do plano.

- Melhoria Mensurável: Planos que passaram por refinamento impulsionado por IA melhoraram em 0,6 a 1,2 pontos em média.

- Insights Comerciais Melhores: Versões refinadas apresentaram maior alinhamento estratégico, projeções financeiras mais claras e mensagens mais persuasivas.

Estes resultados refletem tendências observadas em pesquisa de avaliação de LLM, onde frameworks de classificação estruturados e pontuação iterativa melhoram significativamente o conteúdo gerado por IA.

Pontos Principais

1. A IA Pode Melhorar-se Quando Recebe Critérios de Avaliação Estruturados

- Um framework de pontuação bem definido permite que a IA reconheça e corrija suas próprias fraquezas.

2. A Pontuação Quantitativa Garante A Validação Objetiva Do Conteúdo

- As avaliações subjetivas foram minimizadas através de critérios de avaliação padronizados.

3. O Framework de Avaliação Foi Projetado para Iterações Avançadas de IA, mas o MVP Focou na Velocidade

- A implementação original incluiu múltiplos ciclos de avaliação por seção.

- Devido a restrições de desempenho, simplificamos isso no MVP mas mantivemos para pesquisa e melhoria futuras.

4. Avaliadores de LLM São uma Tendência em Toda a Indústria

- Novos modelos de avaliação de IA (por exemplo, Prometheus 2: Um Modelo de Linguagem de Código Aberto Especializado em Avaliar Outros Modelos de Linguagem, LLMs-as-Judges) estão melhorando a consistência e reduzindo o viés. (arxiv.org)

- O campo de avaliação de IA está evoluindo para estruturas de pontuação multicamadas, validando a abordagem que nós pioneiramos.

Experimente Nosso Conjunto de Negócios com IA

Nós construímos e otimizamos nosso gerador de planos de negócios com IA em DreamHost, garantindo desempenho e escalabilidade de nível empresarial.

Os clientes da DreamHost podem clicar aqui para começar e explorar nosso gerador de planos de negócios com IA e outras ferramentas de IA.

Esta publicação é a Parte 4 de uma série de 4 partes. Certifique-se de conferir as outras publicações da série para um aprofundamento maior no nosso gerador de planos de negócios com IA.

Parte 1: Como Construímos um Gerador de Planos de Negócios com IA Usando LangGraph & LangChain

Parte 2: Como Otimizamos a Geração de Planos de Negócios com IA: Velocidade vs. Compromissos de Qualidade

Parte 3: Como Criamos 273 Testes Unitários em 3 Dias Sem Escrever uma Única Linha de Código

Parte 4: Estrutura de Avaliação de IA — Como Construímos um Sistema para Avaliar e Melhorar Planos de Negócios Gerados por IA