Este post é a Parte 3 de uma série de 4 partes. Certifique-se de conferir os outros posts da série para um aprofundamento no nosso gerador de plano de negócios com IA.

Parte 1: Como Construímos um Gerador de Plano de Negócios com IA Usando LangGraph & LangChain

Parte 2: Como Otimizamos a Geração de Plano de Negócios com IA: Velocidade vs. Compromissos de Qualidade

Parte 3: Como Criamos 273 Testes de Unidade em 3 Dias Sem Escrever uma Única Linha de Código

Parte 4: Framework de Avaliação de IA — Como Construímos um Sistema para Avaliar e Melhorar Planos de Negócios Gerados por IA

Na paisagem em rápida evolução do desenvolvimento de software, o papel da inteligência artificial está se expandindo para além da geração de código, entrando na automação de testes. Durante um período intensivo de três dias em fevereiro de 2025, realizamos um projeto de pesquisa aprofundado na DreamHost avaliando quão eficazmente a IA pode escrever testes unitários de forma autônoma com mínima intervenção humana. Este artigo compartilha os principais achados, métricas e insights que podem reformular a maneira como abordamos a automação de testes.

A Premissa da Pesquisa

O objetivo principal estava claro: avaliar se a IA pode criar testes de unidade de qualidade de produção de forma confiável, sem nenhuma escrita de código humano. Isso não era apenas um exercício acadêmico — na DreamHost, estamos aplicando IA para aumentar nossa produtividade em “100000x” no projeto de Planejador de Negócios com IA, e esta pesquisa foi projetada para expandir ainda mais esses limites. Esta abordagem representa uma mudança significativa dos fluxos de trabalho de teste de unidade tradicionais e poderia impactar dramaticamente a produtividade do desenvolvimento.

Parâmetros do Projeto

Para esta pesquisa, estabelecemos uma metodologia estruturada:

- Entrada de IA: Forneça à IA o código-fonte, arquivos de teste de exemplo mostrando padrões/estilos, requisitos de teste e contexto do ambiente de desenvolvimento

- Limites Humanos: Restrinja a entrada humana a esclarecimentos, correção de equívocos e fornecimento de contexto faltante — sem escrita direta de código

- Foco na Medição: Acompanhe o tempo até a conclusão, iterações necessárias, tipos de erros encontrados, qualidade da saída, cobertura alcançada e esforço humano requerido

Nossos critérios de sucesso eram ambiciosos, mas necessários para aplicabilidade na produção:

- Cobertura de teste de 100%

- Implementação segura de tipo

- Adesão às melhores práticas de teste

- Intervenção humana mínima

- Tempo de conclusão razoável

- Código de teste mantido

Principais Descobertas da Pesquisa

Em apenas três dias, o nosso time acrescentou 273 novos testes ao projeto Business Planner, aumentando dramaticamente a nossa cobertura de testes. Após analisar várias implementações de testes geradas por IA em diferentes serviços e componentes, diversos padrões surgiram que fornecem insights valiosos sobre o estado atual dos testes de unidade dirigidos por IA.

1. Métricas de Eficiência

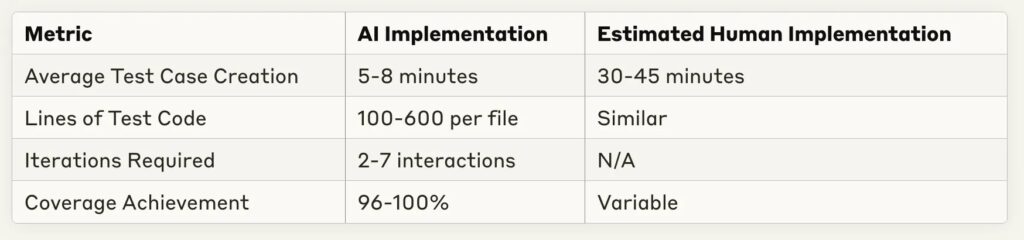

Um dos achados mais impressionantes foi a redução drástica no tempo de implementação:

A economia de tempo é substancial — a maioria das implementações de teste foram completadas em menos de 10 minutos, com um equivalente humano estimado de 30–60 minutos para a mesma tarefa. Isso representa um aumento potencial de produtividade de 4–6x para a escrita de testes rotineiros.

2. Pontos Fortes do Teste de IA

Através de múltiplas implementações, certas capacidades de IA se destacaram consistentemente:

- Cobertura Abrangente: A IA alcançou consistentemente uma cobertura de código de 96–100% em diferentes complexidades de serviço

- Reconhecimento de Padrões: A IA destacou-se no reconhecimento de padrões de teste a partir de exemplos e na aplicação consistente dos mesmos

- Adaptação ao Feedback: A maioria dos erros pôde ser resolvida com esclarecimentos mínimos

- Implementação de Mock: A IA demonstrou fortes capacidades na criação de mocks e fixtures de teste apropriados

- Consistência Estrutural: A organização dos testes seguiu as melhores práticas com padrões claros de arranjo, atuação e afirmação

3. Limitações e Desafios Observados

Apesar dos resultados impressionantes, surgiram vários desafios recorrentes:

- Manipulação de Tipos TypeScript: A fonte mais frequente de erros envolvia definições de tipos incompletas ou suposições incorretas sobre os tipos

- Compreensão da Estrutura do Projeto: Caminhos de importação e relações de dependência frequentemente requeriam correção humana

- Cobertura de Casos Limite: Enquanto os caminhos básicos eram bem cobertos, a lógica condicional complexa às vezes necessitava de casos de teste adicionais

- Suposições de Template: Ocasionalmente, a IA fazia suposições infundadas sobre templates ou padrões específicos da aplicação

- Requisitos de Iteração: Serviços mais complexos requeriam mais interações de ida e volta para alcançar uma cobertura completa

Instantâneos De Estudo De Caso

Vamos examinar algumas implementações representativas para entender melhor esses padrões.

Caso 1: Teste De Exportação De Constante Simples

Para testar arquivos que contêm principalmente exportações constantes:

- Tempo de Implementação: 1 minuto 30 segundos

- Casos de Teste: 10

- Cobertura: 100%

- Iterações: 1 (sem correções necessárias)

- Abordagem: Uso eficaz do teste de snapshot para objetos constantes grandes

Este caso demonstra que, para cenários de teste simples, a IA pode gerar testes completos com zero iterações — essencialmente “perfeitos” na primeira tentativa.

Caso 2: Serviço Complexo com Dependências de DI

Para um serviço mais complexo com injeção de dependência:

- Tempo de Implementação: 4 minutos 50 segundos

- Casos de Teste: 5

- Cobertura: 100%

- Iterações: 2

- Desafios: Implementação de teste Bootstrap requer correções de vinculação de dependências

A IA abordou com sucesso os testes de injeção de dependência, sendo necessários apenas pequenos ajustes para a inicialização do container.

Caso 3: Serviço Altamente Complexo com Muitos Ramos

Para os serviços mais complexos testados:

- Tempo de Implementação: 24 minutos

- Casos de Teste: 11

- Cobertura: 51,26% (abaixo da meta)

- Iterações: 5–6

- Desafios: Dificuldade em alcançar cobertura total de ramificação para lógica condicional complexa

Isso representa um caso limite importante onde a IA ainda enfrentava dificuldades com testes abrangentes de lógicas de ramificação muito complexas.

Implicações Para O Processo De Desenvolvimento

Essas descobertas sugerem várias mudanças na forma como podemos abordar a implementação de testes:

1. Fluxo de Trabalho Revisado

Em vez de desenvolvedores escreverem testes do zero, um fluxo de trabalho mais eficiente parece ser:

- O Desenvolvedor fornece o código-fonte e testes exemplares à IA

- A IA gera uma implementação inicial dos testes

- O Desenvolvedor fornece feedback iterativo sobre questões específicas

- A IA refina a implementação até que os objetivos de cobertura sejam atingidos

- O Desenvolvedor realiza a revisão final e faz o commit

Esta abordagem permite que os desenvolvedores se concentrem em revisar a qualidade dos testes e casos extremos em vez de escrever código de teste padrão.

2. Oportunidades De Otimização

Várias práticas melhoraram significativamente o desempenho da geração de testes de IA:

- Fornecendo exemplos claros de testes no mesmo estilo/padrão

- Especificando os requisitos de cobertura exatos antecipadamente

- Incluindo informações sobre tipos complexos

- Identificando casos limite potenciais proativamente

- Utilizando abordagens de teste primeiro onde a IA tem acesso tanto à implementação quanto aos testes simultaneamente

3. Impacto Econômico

Baseado na comparação entre o tempo de implementação da IA e o tempo estimado de implementação humana, os ganhos potenciais de produtividade são substanciais:

- Redução de 70–85% no tempo gasto escrevendo testes unitários rotineiros

- Maior consistência de cobertura

- Ciclos de feedback mais rápidos durante o desenvolvimento

- Mais casos de teste para o mesmo esforço de desenvolvimento

Olhando Para Frente: O Futuro dos Testes Impulsionados por IA

Esta pesquisa representa uma investigação inicial sobre o que provavelmente se tornará uma prática padrão de desenvolvimento. Várias tendências indicam para onde este campo está se direcionando:

Oportunidades Futuras

- Desenvolvimento Orientado por Testes: A IA poderia gerar tanto os testes quanto o código de implementação de forma iterativa

- Integração com CI/CD: Geração e manutenção de testes automatizados durante o processo de construção

- Treinamento de Domínio Personalizado: Ajuste fino de modelos para bases de código específicas ou padrões

- Testes Auto-Curativos: IA que atualiza testes quando há alterações na implementação

- Modelos de Teste Especializados: Modelos de IA especificamente otimizados para geração de testes

Desafios Restantes

Apesar de um progresso significativo, vários desafios permanecem:

- Gestão de Estado Complexo: Testando componentes com estados e interações complexas

- Conhecimento Especializado: Testes que requerem insights específicos do domínio ou regras de negócio

- Testes de Integração: Avançando além dos testes unitários para testes de integração e de sistema

- Testes de Desempenho: Identificando e escrevendo testes de desempenho eficazes

- Testes de Segurança: Encontrando e explorando vulnerabilidades de segurança

Resumo do Projeto: Os Números

Aqui está um resumo do que alcançamos no nosso experimento de três dias:

- Adições de Teste: 273 novos testes adicionados (de 22 para 295 no total)

- Taxa de Sucesso: ~90% das tentativas alcançaram cobertura de 100% com sucesso

- Tempo de Implementação: Média de 5–8 minutos por componente

- Maior Conjunto de Testes: 273 testes adicionados em aproximadamente 6 horas de trabalho total

- Implementação Mais Rápida: 90 segundos para snapshots de framework com cobertura de 100%

- Caso Mais Complexo: Componente de gráfico com 13 dependências, concluído em 5 minutos

- Nível de Qualidade: Manteve a qualidade de código no nível de desenvolvedor sênior

- Input Humano: Zero linhas de código escritas por humanos

Sob a perspectiva do ROI, estimamos uma economia de tempo de 70–80% em comparação com a implementação manual, sem comprometer a qualidade. A única falha notável foi com o RunsService, onde alcançamos apenas 51% de cobertura devido à lógica de ramificação extremamente complexa.

Conclusão: Recomendações Práticas

Com base nesta pesquisa, recomendamos as seguintes práticas para equipes que desejam usar a IA para testes de unidade:

- Comece Simples: Comece com componentes simples que seguem padrões estabelecidos

- Forneça Exemplos: Inclua exemplos representativos do seu estilo de teste

- Feedback Iterativo: Planeje 2–3 ciclos de feedback para alcançar resultados ótimos

- Foque em Casos Limite: Use seu conhecimento do domínio para sugerir casos limite que a IA pode não detectar

- Estabeleça Diretrizes Claras: Defina o que significa “concluído” para a cobertura e estilo de teste

- Atualizações Regulares: À medida que os modelos de IA melhoram, revise sua abordagem para aproveitar novas capacidades

O aspecto mais empolgante desta pesquisa é que ela representa apenas o começo. À medida que as capacidades da IA continuam a evoluir, o potencial para testes impulsionados por IA se expandirá por domínios de teste mais complexos, transformando finalmente a maneira como abordamos a garantia de qualidade no desenvolvimento de software.

Esta pesquisa foi conduzida ao longo de três dias em fevereiro de 2025 no projeto Planejador de Negócios com IA da DreamHost, utilizando vários modelos de IA incluindo GitHub Copilot, os modelos GPT da OpenAI e o Claude da Anthropic. O ambiente de teste foi um serviço baseado em TypeScript com Jest e ts-mockito para testes, focando em componentes de aplicação empresarial do mundo real. Mais importante ainda, não escrevemos nenhuma linha de código durante todo o processo — toda a implementação dos testes foi feita por IA com apenas orientação humana.

Este post é a Parte 3 de uma série de 4 partes. Certifique-se de conferir os outros posts da série para um mergulho mais profundo no nosso gerador de plano de negócios com IA.

Parte 1: Como Construímos um Gerador de Plano de Negócios com IA Usando LangGraph & LangChain

Parte 2: Como Otimizamos a Geração de Planos de Negócios com IA: Velocidade vs. Qualidade

Parte 3: Como Criamos 273 Testes de Unidade em 3 Dias Sem Escrever uma Única Linha de Código

Parte 4: Estrutura de Avaliação de IA — Como Construímos um Sistema para Avaliar e Melhorar Planos de Negócios Gerados por IA