Questo post è la Parte 3 di una serie di 4 parti. Assicurati di controllare gli altri post della serie per approfondire il nostro generatore di piani di business alimentato da IA.

Parte 1: Come Abbiamo Costruito un Generatore di Piani di Business Alimentato da IA Usando LangGraph & LangChain

Parte 2: Come Abbiamo Ottimizzato la Generazione di Piani di Business IA: Velocità vs Compromessi sulla Qualità

Parte 3: Come Abbiamo Creato 273 Test di Unità in 3 Giorni Senza Scrivere una Singola Linea di Codice

Parte 4: Framework di Valutazione IA — Come Abbiamo Costruito un Sistema per Valutare e Migliorare i Piani di Business Generati dall’IA

Nel panorama in rapida evoluzione dello sviluppo software, il ruolo dell’intelligenza artificiale si sta espandendo oltre la generazione del codice fino all’automazione dei test. Durante un intenso periodo di tre giorni nel febbraio 2025, abbiamo condotto un progetto di ricerca approfondito presso DreamHost valutando quanto efficacemente l’IA possa scrivere autonomamente test unitari con minimo intervento umano. Questo articolo condivide i risultati principali, le metriche e le intuizioni che potrebbero ridisegnare il modo in cui affrontiamo l’automazione dei test.

La Premessa Della Ricerca

L’obiettivo principale era chiaro: valutare se l’IA può creare in modo affidabile test di unità di qualità produttiva senza scrivere codice umano. Questo non era solo un esercizio accademico — a DreamHost, stiamo applicando l’IA per “100000x” la nostra produttività nel progetto Pianificatore Aziendale e questa ricerca è stata progettata per spingere ulteriormente questi limiti. Questo approccio rappresenta un significativo cambiamento rispetto ai flussi di lavoro tradizionali di test di unità e potrebbe impattare in modo notevole sulla produttività dello sviluppo.

Parametri del Progetto

Per questa ricerca, abbiamo stabilito una metodologia strutturata:

- Input IA: Fornisci all’IA il codice sorgente, file di test di esempio che mostrano schemi/stile, requisiti di test e contesto dell’ambiente di sviluppo

- Limiti Umani: Limita gli input umani a chiarimenti, correzione di concetti errati e fornitura di contesto mancante — senza scrittura diretta del codice

- Focus sulla Misurazione: Traccia il tempo di completamento, le iterazioni necessarie, i tipi di errori incontrati, la qualità dell’output, la copertura raggiunta e lo sforzo umano richiesto

I nostri criteri di successo erano ambiziosi ma necessari per l’applicabilità alla produzione:

- Copertura dei test al 100%

- Implementazione a tipizzazione sicura

- Adesione alle migliori pratiche di testing

- Minimo intervento umano

- Tempo di completamento ragionevole

- Codice di test manutenibile

Principali Risultati Della Ricerca

In soli tre giorni, il nostro team ha aggiunto 273 nuovi test al progetto Business Planner, aumentando notevolmente la copertura dei test. Dopo aver analizzato diverse implementazioni di test generate da IA su vari servizi e componenti, sono emersi diversi schemi che offrono preziose intuizioni sullo stato attuale dei test di unità guidati da IA.

1. Metriche di Efficienza

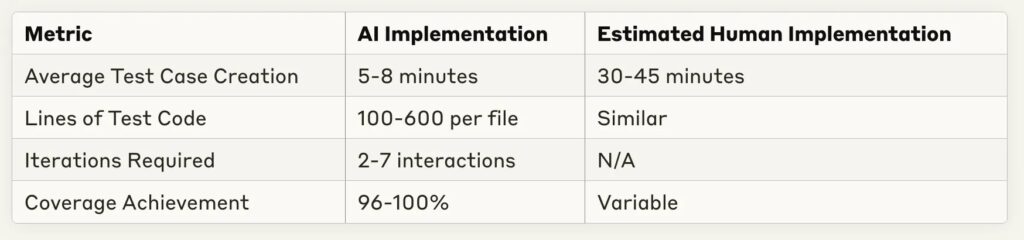

Uno dei risultati più sorprendenti è stata la drammatica riduzione del tempo di implementazione:

Il risparmio di tempo è sostanziale — la maggior parte delle implementazioni di test sono state completate in meno di 10 minuti, con un equivalente umano stimato di 30–60 minuti per lo stesso compito. Questo rappresenta un potenziale aumento della produttività del 4–6x per la scrittura di test di routine.

2. Punti di Forza del Test IA

Attraverso molteplici implementazioni, alcune capacità dell’IA si sono costantemente distinte:

- Copertura Completa: L’IA ha raggiunto costantemente una copertura del codice del 96-100% attraverso diverse complessità di servizi

- Riconoscimento di Pattern: L’IA ha eccelso nel riconoscere pattern di test da esempi e applicarli in modo coerente

- Adattamento al Feedback: La maggior parte degli errori poteva essere risolta con minime chiarificazioni

- Implementazione di Mock: L’IA ha dimostrato forti capacità nella creazione di mock e fixture di test appropriati

- Consistenza Strutturale: L’organizzazione dei test ha seguito le migliori pratiche con schemi chiari di arrange-act-assert

3. Limitazioni e Sfide Osservate

Nonostante i risultati impressionanti, sono emerse diverse sfide ricorrenti:

- Gestione Dei Tipi In TypeScript: La fonte più frequente di errori è stata rappresentata da definizioni di tipo incomplete o ipotesi errate sui tipi

- Comprensione Della Struttura Del Progetto: I percorsi di importazione e le relazioni di dipendenza hanno spesso richiesto correzioni manuali

- Copertura Dei Casi Limite: Sebbene i percorsi base fossero ben coperti, la logica condizionale complessa talvolta necessitava di casi di test aggiuntivi

- Ipotesi Sui Template: L’IA ha occasionalmente formulato ipotesi infondate sui template specifici dell’applicazione o sui modelli

- Requisiti Di Iterazione: I servizi più complessi hanno richiesto più scambi avanti e indietro per raggiungere una copertura completa

Istantanee Di Casi Studio

Esaminiamo alcune implementazioni rappresentative per comprendere meglio questi schemi.

Caso 1: Test Sull’Esportazione Di Costanti Semplici

Per testare file che contengono principalmente esportazioni costanti:

- Tempo Di Implementazione: 1 minuto 30 secondi

- Casi Di Test: 10

- Copertura: 100%

- Iterazioni: 1 (nessuna correzione necessaria)

- Approccio: Uso efficace dei test di snapshot per grandi oggetti costanti

Questo caso dimostra che per scenari di test semplici, l’IA può generare test completi senza iterazioni — essenzialmente “perfetti” al primo tentativo.

Caso 2: Servizio Complesso con Dipendenze DI

Per un servizio più complesso con iniezione di dipendenza:

- Tempo di Implementazione: 4 minuti 50 secondi

- Casi di Test: 5

- Copertura: 100%

- Iterazioni: 2

- Sfide: Necessaria l’implementazione del test Bootstrap per correggere le dipendenze

L’IA ha affrontato con successo i test di iniezione delle dipendenze, necessitando solo di piccoli aggiustamenti per l’inizializzazione del contenitore.

Caso 3: Servizio Altamente Complesso con Molti Ramificazioni

Per i servizi più complessi testati:

- Tempo Di Implementazione: 24 minuti

- Casi Di Test: 11

- Copertura: 51,26% (sotto l’obiettivo)

- Iterazioni: 5–6

- Sfide: Difficoltà nel raggiungere la copertura completa dei rami per logiche condizionali complesse

Questo rappresenta un caso limite importante in cui l’IA ha ancora difficoltà con test completi di logiche di ramificazione molto complesse.

Implicazioni per il Processo di Sviluppo

Questi risultati suggeriscono diversi cambiamenti nel modo in cui potremmo affrontare l’implementazione dei test:

1. Flusso di Lavoro Rivisto

Piuttosto che gli sviluppatori scrivano test da zero, un flusso di lavoro più efficiente sembra essere:

- Lo sviluppatore fornisce il codice sorgente e i test di esempio all’IA

- L’IA genera l’implementazione iniziale dei test

- Lo sviluppatore fornisce feedback iterativi su questioni specifiche

- L’IA affina l’implementazione fino al raggiungimento degli obiettivi di copertura

- Lo sviluppatore esegue la revisione finale e conferma le modifiche

Questo approccio permette agli sviluppatori di concentrarsi sulla revisione della qualità dei test e sui casi limite piuttosto che sulla scrittura di codice di test standard.

2. Opportunità Di Ottimizzazione

Diverse pratiche hanno migliorato significativamente le prestazioni della generazione di test IA:

- Fornire chiari esempi di test nello stesso stile/modello

- Specificare in anticipo i requisiti esatti di copertura

- Includere informazioni sui tipi complessi

- Identificare proattivamente i casi limite potenziali

- Utilizzare approcci test-first dove l’IA ha accesso sia all’implementazione che ai test contemporaneamente

3. Impatto Economico

Basandosi sul confronto tra il tempo di implementazione dell’IA e il tempo di implementazione umano stimato, i potenziali guadagni di produttività sono sostanziali:

- Riduzione del 70-85% del tempo impiegato nella scrittura di test unitari di routine

- Maggiore consistenza della copertura

- Cicli di feedback più rapidi durante lo sviluppo

- Più casi di test per lo stesso sforzo di sviluppo

Guardando Avanti: Il Futuro dei Test Guidati dall’IA

Questa ricerca rappresenta una prima indagine su quello che probabilmente diventerà una pratica standard di sviluppo. Diverse tendenze indicano la direzione verso cui si sta orientando questo campo:

Opportunità Future

- Sviluppo Guidato dai Test: L’IA potrebbe generare iterativamente sia i test che il codice di implementazione

- Integrazione con CI/CD: Generazione e manutenzione automatica dei test durante il processo di costruzione

- Formazione su Dominio Personalizzato: Modelli di messa a punto per basi di codice o schemi specifici

- Test Auto-Rigeneranti: IA che aggiorna i test quando cambia l’implementazione

- Modelli di Test Specializzati: Modelli di IA specificamente ottimizzati per la generazione di test

Sfide Rimaste

Nonostante i significativi progressi, rimangono diverse sfide:

- Gestione Dello Stato Complessa: Testare componenti stateful con interazioni complesse

- Conoscenza Specializzata: Test che richiedono conoscenze specifiche del settore o regole aziendali

- Test di Integrazione: Oltre i test unitari verso test di integrazione e di sistema

- Test delle Prestazioni: Identificare e scrivere test di prestazione efficaci

- Test di Sicurezza: Trovare e sfruttare le vulnerabilità di sicurezza

Riepilogo Del Progetto: I Numeri

Ecco uno scorcio di ciò che abbiamo raggiunto nel nostro esperimento di tre giorni:

- Aggiunte di Test: aggiunti 273 nuovi test (da 22 a 295 totali)

- Tasso di Successo: circa il 90% dei tentativi ha raggiunto con successo una copertura del 100%

- Tempo di Implementazione: Media di 5–8 minuti per componente

- Test Suite Più Grande: aggiunti 273 test in circa 6 ore di lavoro totale

- Implementazione Più Rapida: 90 secondi per gli snapshot di framework con copertura del 100%

- Caso Più Complesso: componente Grafico con 13 dipendenze, completato in 5 minuti

- Livello di Qualità: mantenuta la qualità del codice a livello di sviluppatore senior

- Input Umano: Zero righe di codice scritte da umani

Da un punto di vista del ROI, stimiamo un risparmio del tempo del 70–80% rispetto all’implementazione manuale, senza compromessi sulla qualità. L’unico fallimento degno di nota è stato con il RunsService, dove abbiamo raggiunto solo il 51% di copertura a causa della logica di ramificazione estremamente complessa.

Conclusione: Raccomandazioni Pratiche

Sulla base di questa ricerca, raccomandiamo le seguenti pratiche per i team che desiderano sfruttare l’IA per il testing unitario:

- Inizia Semplice: Comincia con componenti semplici che seguono schemi consolidati

- Fornisci Esempi: Includi esempi rappresentativi del tuo stile di test

- Feedback Iterativo: Pianifica 2–3 cicli di feedback per ottenere risultati ottimali

- Concentrati sui Casi Limite: Usa la tua conoscenza del dominio per suggerire casi limite che l’IA potrebbe non considerare

- Stabilisci Linee Guida Chiare: Definisci cosa significa “completato” per la copertura dei test e lo stile

- Aggiornamenti Regolari: Man mano che i modelli di IA migliorano, rivedi il tuo approccio per sfruttare le nuove capacità

L’aspetto più entusiasmante di questa ricerca è che rappresenta solo l’inizio. Man mano che le capacità dell’IA continuano a evolversi, il potenziale per i test guidati dall’IA si espanderà in domini di test più complessi, trasformando in ultima analisi il modo in cui affrontiamo l’assicurazione della qualità nello sviluppo del software.

Questa ricerca è stata condotta in tre giorni di febbraio 2025 sul progetto del Pianificatore Aziendale IA di DreamHost, utilizzando diversi modelli di IA, inclusi GitHub Copilot, i modelli GPT di OpenAI e Claude di Anthropic. L’ambiente di test era un servizio basato su TypeScript con Jest e ts-mockito per i test, concentrato sui componenti delle applicazioni aziendali reali. Soprattutto, non abbiamo scritto nessuna riga di codice durante l’intero processo — tutta l’implementazione dei test è stata effettuata da IA con solo la guida umana.

Questo post è la Parte 3 di una serie in 4 parti. Assicurati di controllare gli altri post della serie per approfondire il nostro generatore di piani aziendali alimentato da IA.

Parte 1: Come Abbiamo Creato un Generatore di Piani Aziendali Alimentato da IA Usando LangGraph & LangChain

Parte 2: Come Abbiamo Ottimizzato la Generazione di Piani Aziendali IA: Velocità vs. Compromessi sulla Qualità

Parte 3: Come Abbiamo Creato 273 Test Unitari in 3 Giorni Senza Scrivere una Singola Linea di Codice

Parte 4: Struttura di Valutazione IA — Come Abbiamo Costruito un Sistema per Valutare e Migliorare i Piani Aziendali Generati dall’IA