Questo post è la Parte 4 di una serie in 4 parti. Assicurati di dare un’occhiata agli altri post della serie per un’analisi più approfondita del nostro generatore di piani aziendali alimentato da IA.

Parte 1: Come abbiamo costruito un generatore di piani aziendali alimentato da IA usando LangGraph & LangChain

Parte 2: Come abbiamo ottimizzato la generazione di piani aziendali IA: velocità contro qualità

Parte 3: Come abbiamo creato 273 test di unità in 3 giorni senza scrivere una sola riga di codice

Parte 4: Framework di Valutazione IA — Come abbiamo costruito un sistema per valutare e migliorare i piani aziendali generati dall’IA

Introduzione: La Sfida della Valutazione dei Piani Aziendali IA

Valutare oggettivamente i contenuti generati dall’IA è complesso. A differenza degli output strutturati con risposte chiaramente giuste o sbagliate, i piani aziendali comportano pensiero strategico, valutazioni di fattibilità e coerenza, rendendo la valutazione altamente soggettiva.

Questo ha sollevato sfide importanti:

- Come possiamo quantificare il contenuto di un piano aziendale “buono” contro “cattivo”?

- Come possiamo garantire che l’IA si auto-migliori nel tempo?

- Come rendiamo la valutazione coerente e imparziale?

Per risolvere questo, abbiamo sviluppato un framework strutturato di valutazione che ci permette di valutare, iterare e migliorare i piani aziendali generati dall’IA. Il nostro approccio ha combinato diversi framework di valutazione, ciascuno adattato a diverse sezioni del piano, garantendo sia precisione che profondità strategica.

È importante notare che questo sistema di valutazione dettagliato faceva parte della nostra implementazione originale, dove ogni sezione è stata sottoposta a valutazione rigorosa e iterazione. Tuttavia, a causa dei vincoli di prestazione, abbiamo semplificato il processo di valutazione nell’MVP per dare priorità alla velocità di generazione. Questo compromesso ci ha aiutato a implementare più rapidamente mantenendo il quadro di valutazione come parte della ricerca continua per miglioramenti futuri.

Recenti ricerche nell’evaluazione basata su LLM hanno confermato l’efficacia della valutazione AI strutturata. Studi come Prometheus 2: Un Modello di Linguaggio Open Source Specializzato nella Valutazione di Altri Modelli di Linguaggio (2024) e il framework Evals di OpenAI hanno dimostrato che i LLM possono essere valutatori affidabili quando guidati da criteri di punteggio strutturati.

Progettazione del Framework di Valutazione

Ci siamo ispirati ai sistemi di valutazione degli insegnanti e li abbiamo applicati ai piani aziendali generati dall’IA. Questo ha portato alla creazione di diversi framework di valutazione, ognuno adattato a differenti tipi di sezioni.

Framework di Valutazione per Tipo di Sezione

Invece di utilizzare un metodo di valutazione universalmente applicabile, abbiamo sviluppato criteri di valutazione personalizzati a seconda del tipo di contenuto valutato:

Pianificazione Strategica & Modello di Business

- Valutato per chiarezza, allineamento agli obiettivi SMART e fattibilità.

- Richiesti piani d’azione espliciti e definizione strutturata degli obiettivi.

Ricerca di Mercato & Analisi Competitiva

- Concentrato sulla profondità della ricerca, differenziazione e validazione dei dati reali.

- Le risposte dell’IA sono state valutate su realismo di mercato e posizionamento competitivo.

Pianificazione Finanziaria & Proiezioni

- Valutazione delle ipotesi finanziarie, modellazione dei ricavi e analisi delle spese.

- I risultati dell’IA dovevano essere quantificabili, coerenti internamente e ragionevoli.

Strategia Operativa & di Esecuzione

- Punteggiato in base a fattibilità, mitigazione del rischio e roadmap di esecuzione.

- Necessaria una chiara struttura di team e allocazione delle risorse.

Strategia di Marketing & Vendite

- Valutato in base all’allineamento con il pubblico di riferimento, al potenziale di conversione e alla coerenza del brand.

- I piani di marketing generati dall’IA dovevano essere specifici e basati su dati.

Ogni Framework assegna pesi a diverse dimensioni di valutazione, assicurando che le aree critiche (ad esempio, la sostenibilità finanziaria) influenzino il punteggio complessivo più di quelle meno critiche. Questo è in linea con i recenti risultati di Prometheus 2: Un Modello di Linguaggio Open Source Specializzato nella Valutazione di Altri Modelli di Linguaggio, che hanno sottolineato la necessità di benchmark di valutazione dettagliati usando LLM.

Meccanismo Di Valutazione Del Punteggio

Ogni sezione è stata valutata da 1 a 5, seguendo una rubrica:

Miglioramento Iterativo Basato Su IA

Per consentire all’IA di migliorarsi autonomamente, abbiamo progettato un ciclo di feedback multi-step:

Passo 1: Generazione Bozza

- L’IA genera una bozza iniziale basata sugli input degli utenti.

- Le sezioni sono strutturate secondo modelli predefiniti.

Passaggio 2: Autovalutazione IA

- L’IA rivede il proprio output contro i framework di valutazione specifici per sezione.

- Individua aree con dati mancanti, spiegazioni vaghe o allineamento strategico debole.

Passo 3: Auto Miglioramento con IA

- L’IA rigenera le sezioni deboli, garantendo un migliore allineamento con i criteri di valutazione.

- Se mancano dati finanziari o analisi di mercato, l’IA aggiusta le ipotesi e il ragionamento.

Passo 4: Valutazione Finale

- L’IA effettua una seconda valutazione per confermare i propri miglioramenti.

- La versione finale viene confrontata con le versioni precedenti per monitorare i progressi.

Questo processo iterativo genera → valuta → migliora è in linea con la ricerca all’avanguardia che dimostra che le valutazioni basate su LLM migliorano attraverso passaggi multipli.

Validazione Statistica: Ha Davvero Funzionato?

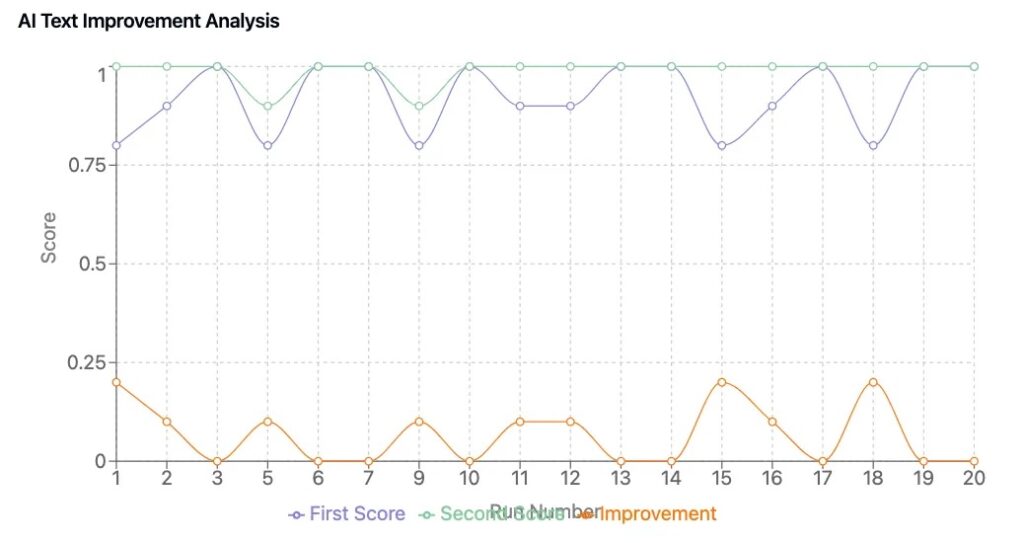

Per confermare che il nostro Framework ha portato a miglioramenti tangibili, abbiamo eseguito un ciclo di test di 50 piani, confrontando i piani aziendali generati dall’IA con e senza cicli di auto-miglioramento.

Risultati Chiave

- Coerenza del Punteggio: I contenuti generati dall’IA hanno ottenuto punteggi consistenti, riducendo le fluttuazioni casuali nella qualità dei piani.

- Miglioramento Misurabile: I piani che hanno subito un perfezionamento guidato dall’IA sono migliorati di da 0,6 a 1,2 punti in media.

- Migliori Intuizioni Commerciali: Le versioni perfezionate presentavano un allineamento strategico più marcato, proiezioni finanziarie più chiare e messaggi più persuasivi.

Questi risultati rispecchiano le tendenze osservate nella ricerca di valutazione degli LLM, dove i framework di valutazione strutturati e la punteggiatura iterativa migliorano significativamente i contenuti generati dall’IA.

Punti Chiave

1. L’IA Può Migliorarsi Automaticamente Quando Riceve Criteri di Valutazione Strutturati

- Un framework di valutazione ben definito permette all’IA di riconoscere e correggere le proprie debolezze.

2. La Valutazione Quantitativa Garantisce La Validazione Oggettiva Dei Contenuti

- Le valutazioni soggettive sono state ridotte attraverso griglie di valutazione standardizzate.

3. Il Framework Di Valutazione È Stato Progettato Per Iterazioni Avanzate Di IA, Ma L’MVP Si È Concentrato Sulla Velocità

- L’implementazione originale includeva più cicli di valutazione per sezione.

- A causa dei vincoli di prestazione, abbiamo semplificato questo nell’MVP ma lo abbiamo mantenuto per future ricerche e miglioramenti.

4. I Valutatori LLM Sono una Tendenza a Livello di Settore

- I nuovi modelli di valutazione IA (ad es., Prometheus 2: Un Modello di Linguaggio Open Source Specializzato nella Valutazione di Altri Modelli di Linguaggio, LLMs-as-Judges) stanno migliorando la coerenza e riducendo il pregiudizio. (arxiv.org)

- Il campo della valutazione IA si sta evolvendo verso framework di punteggio multi-strato, validando l’approccio che abbiamo pionierato.

Prova la Nostra Suite Aziendale con IA

Abbiamo costruito e ottimizzato il nostro generatore di piani aziendali guidato da IA presso DreamHost, garantendo prestazioni e scalabilità a livello aziendale.

I clienti di DreamHost possono cliccare qui per iniziare ed esplorare il nostro generatore di piani aziendali con IA e altri strumenti IA.

Questo post è la Parte 4 di una serie in 4 parti. Assicurati di leggere gli altri post della serie per approfondire il nostro generatore di piani aziendali alimentato da IA.

Parte 1: Come Abbiamo Costruito un Generatore di Piani Aziendali Alimentato da IA Utilizzando LangGraph & LangChain

Parte 2: Come Abbiamo Ottimizzato la Generazione di Piani Aziendali IA: Velocità contro Compromessi di Qualità

Parte 3: Come Abbiamo Creato 273 Test Unitari in 3 Giorni Senza Scrivere una Singola Linea di Codice

Parte 4: Framework di Valutazione IA — Come Abbiamo Costruito un Sistema per Valutare e Migliorare i Piani Aziendali Generati dall’IA