Ce post est la partie 4 d’une série en 4 parties. Assure-toi de consulter les autres posts de la série pour approfondir notre générateur de plans d’affaires alimenté par l’IA.

Partie 1 : Comment nous avons construit un générateur de plans d’affaires alimenté par l’IA utilisant LangGraph & LangChain

Partie 2 : Comment nous avons optimisé la génération de plans d’affaires IA : Vitesse contre qualité

Partie 3 : Comment nous avons créé 273 tests unitaires en 3 jours sans écrire une seule ligne de code

Partie 4 : Cadre d’évaluation IA — Comment nous avons construit un système pour évaluer et améliorer les plans d’affaires générés par l’IA

Introduction : Le Défi de l’Évaluation des Plans d’Entreprise IA

Évaluer objectivement le contenu généré par l’IA est complexe. Contrairement aux sorties structurées avec des réponses clairement justes ou fausses, les plans d’entreprise impliquent une réflexion stratégique, des évaluations de faisabilité et de la cohérence, rendant l’évaluation très subjective.

Cela a soulevé des défis clés :

- Comment quantifier le contenu d’un plan d’affaires “bon” contre “mauvais”?

- Comment pouvons-nous garantir que l’IA s’améliore avec le temps?

- Comment rendre l’évaluation cohérente et impartiale?

Pour résoudre cela, nous avons développé un cadre de notation structuré qui nous permet de évaluer, itérer et améliorer les plans d’affaires générés par IA. Notre approche a combiné plusieurs cadres d’évaluation, chacun adapté à différentes sections du plan, garantissant à la fois la précision et la profondeur stratégique.

Il est important de noter que ce système d’évaluation détaillé faisait partie de notre mise en œuvre initiale, où chaque section a subi une évaluation rigoureuse et une itération. Cependant, en raison de contraintes de performance, nous avons simplifié le processus d’évaluation dans le MVP pour prioriser la vitesse de génération. Ce compromis nous a aidés à déployer plus rapidement tout en conservant le cadre d’évaluation comme partie de la recherche continue pour des améliorations futures.

Des recherches récentes en évaluation basée sur LLM ont confirmé l’efficacité de l’évaluation structurée de l’IA. Des études telles que Prometheus 2 : Un modèle de langue open source spécialisé dans l’évaluation d’autres modèles de langue (2024) et le cadre Evals d’OpenAI ont démontré que les LLM peuvent être des évaluateurs fiables lorsqu’ils sont guidés par des critères de notation structurés.

Conception du Cadre d’Évaluation

Nous nous sommes inspirés des systèmes de notation des enseignants et les avons appliqués aux plans d’affaires générés par IA. Cela a conduit à la création de plusieurs cadres d’évaluation, chacun adapté à différents types de sections.

Cadres D’Évaluation Par Type de Section

Au lieu d’utiliser une méthode d’évaluation unique, nous avons développé des critères de notation personnalisés selon le type de contenu évalué :

Planification stratégique & Modèle d’affaires

- Évalué pour la clarté, l’alignement des objectifs SMART et la faisabilité.

- Requiert des plans d’action explicites et une définition structurée des objectifs.

Étude de Marché & Analyse Concurrentielle

- Concentré sur la profondeur de la recherche, la différenciation et la validation des données réelles.

- Les réponses de l’IA ont été évaluées sur le réalisme du marché et le positionnement concurrentiel.

Planification Financière & Projections

- Évaluation des hypothèses financières, modélisation des revenus et ventilation des dépenses.

- Les résultats de l’IA devaient être quantifiables, cohérents en interne et raisonnables.

Stratégie Opérationnelle & d’Exécution

- Évalué sur la faisabilité, l’atténuation des risques et la feuille de route de l’exécution.

- Requis une structure d’équipe claire et une allocation des ressources.

Stratégie Marketing & Ventes

- Évalué en fonction de l’alignement sur le public cible, du potentiel de conversion et de la cohérence de la marque.

- Les plans marketing générés par IA devaient être spécifiques et basés sur des données.

Chaque Framework attribuait des poids à différentes dimensions d’évaluation, s’assurant que les domaines critiques (par exemple, la viabilité financière) influençaient le score global plus que les domaines moins critiques. Cela est en accord avec les découvertes récentes de Prometheus 2 : Un Modèle de Langue Open Source Spécialisé dans l’Évaluation d’Autres Modèles de Langue, qui soulignait la nécessité de benchmarks d’évaluation détaillés utilisant des LLMs.

Mécanisme de Notation d’Évaluation

Chaque section était notée de 1 à 5, suivant une grille d’évaluation :

Amélioration Itérative Pilotée par IA

Pour permettre à l’IA de s’améliorer elle-même, nous avons conçu une boucle de rétroaction à plusieurs étapes:

Étape 1 : Génération de Brouillon

- L’IA génère un brouillon initial basé sur les entrées de l’utilisateur.

- Les sections sont structurées selon des modèles prédéfinis.

Étape 2 : Auto-Évaluation IA

- L’IA révise ses propres résultats par rapport aux cadres d’évaluation spécifiques à la section.

- Identifie les zones avec des données manquantes, des explications floues ou un alignement stratégique faible.

Étape 3 : Auto-amélioration IA

- L’IA régénère les sections faibles, assurant une meilleure adéquation avec les critères d’évaluation.

- Si les données financières ou l’analyse de marché sont insuffisantes, l’IA ajuste les hypothèses et le raisonnement.

Étape 4 : Évaluation Finale

- L’IA effectue un second passage de notation pour valider ses propres améliorations.

- La version finale est comparée aux itérations précédentes pour suivre les progrès.

Ce processus itératif de génération → évaluation → amélioration s’aligne sur des recherches de pointe montrant que les évaluations basées sur LLM s’améliorent sur plusieurs passages.

Validation Statistique : A-t-elle Réellement Fonctionné ?

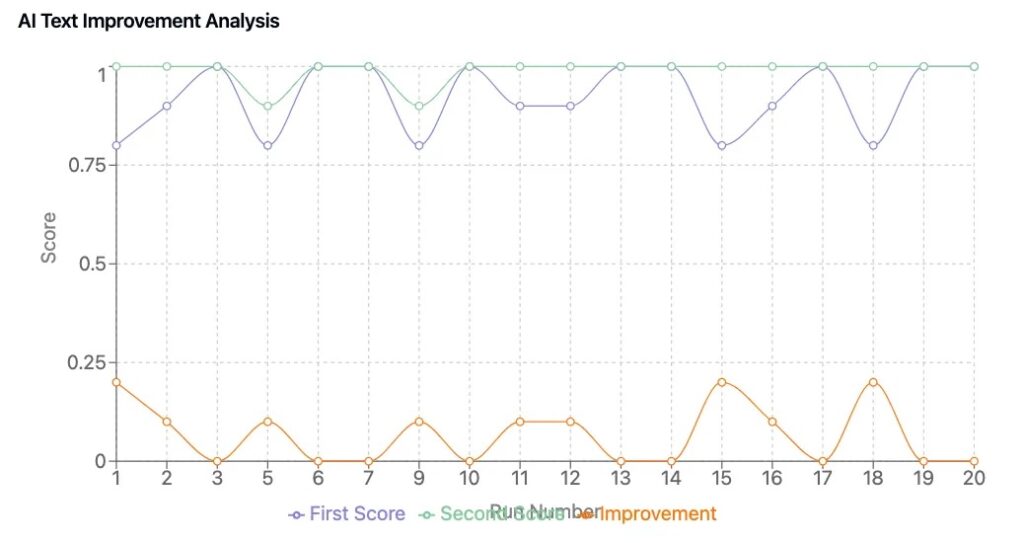

Pour confirmer que notre Framework a conduit à des améliorations tangibles, nous avons réalisé un cycle de test de 50 plans, comparant les plans d’entreprise générés par IA avec et sans boucles d’auto-amélioration.

Principales Découvertes

- Cohérence De La Notation : Le contenu généré par l’IA a une cohérence de notation, réduisant les fluctuations aléatoires dans la qualité des plans.

- Amélioration Mesurable : Les plans qui ont subi un raffinement piloté par l’IA se sont améliorés de 0,6 à 1,2 points en moyenne.

- Meilleures Perspectives Commerciales : Les versions raffinées présentaient un alignement stratégique plus fort, des projections financières plus claires et un message plus persuasif.

Ces résultats reflètent les tendances observées dans la recherche d’évaluation des LLM, où les cadres de notation structurés et la notation itérative améliorent considérablement le contenu généré par IA.

Points Clés

1. L’IA Peut S’améliorer Elle-Même Lorsqu’on Lui Donne Des Critères D’évaluation Structurés

- Un cadre d’évaluation bien défini permet à l’IA de reconnaître et de corriger ses propres faiblesses.

2. La Notation Quantitative Assure Une Validation Objective Du Contenu

- Les évaluations subjectives ont été minimisées grâce à des barèmes de notation standardisés.

3. Le Cadre d’Évaluation A Été Conçu Pour Des Itérations d’IA Avancées, Mais Le MVP a Privilegié La Vitesse

- L’implémentation originale comprenait plusieurs cycles d’évaluation par section.

- En raison de contraintes de performance, nous avons simplifié cela dans le MVP mais l’avons conservé pour des recherches et améliorations futures.

4. Les Évaluateurs LLM Sont Une Tendance À L’échelle De L’industrie

- Les nouveaux modèles d’évaluation de l’IA (par exemple, Prometheus 2 : Un modèle de langage open source spécialisé dans l’évaluation d’autres modèles de langages, LLMs-as-Judges) améliorent la cohérence et réduisent les biais. (arxiv.org)

- Le domaine de l’évaluation de l’IA évolue vers des cadres de notation multicouches, validant l’approche que nous avons pionnière.

Essaie Notre Suite Commerciale Propulsée Par L’IA

Nous avons construit et optimisé notre générateur de plan d’entreprise piloté par IA chez DreamHost, garantissant des performances et une évolutivité de niveau entreprise.

Les clients de DreamHost peuvent cliquer ici pour commencer et explorer notre générateur de plans d’affaires avec IA et d’autres outils IA.

Ce post est la Partie 4 d’une série en 4 parties. Assure-toi de consulter les autres posts de la série pour une exploration approfondie de notre générateur de plans d’affaires alimenté par l’IA.

Partie 1 : Comment nous avons construit un générateur de plans d’affaires alimenté par l’IA en utilisant LangGraph & LangChain

Partie 2 : Comment nous avons optimisé la génération de plans d’affaires IA : Vitesse contre qualité

Partie 3 : Comment nous avons créé 273 tests unitaires en 3 jours sans écrire une seule ligne de code

Partie 4 : Cadre d’évaluation IA — Comment nous avons construit un système pour évaluer et améliorer les plans d’affaires générés par l’IA