Ce billet est la Partie 3 d’une série en 4 parties. Assure-toi de consulter les autres billets de la série pour approfondir notre générateur de plans d’affaires piloté par IA.

Partie 1 : Comment nous avons construit un générateur de plans d’affaires piloté par IA en utilisant LangGraph & LangChain

Partie 2 : Comment nous avons optimisé la génération de plans d’affaires IA : Vitesse contre qualité

Partie 3 : Comment nous avons créé 273 tests unitaires en 3 jours sans écrire une seule ligne de code

Partie 4 : Cadre d’évaluation IA — Comment nous avons construit un système pour évaluer et améliorer les plans d’affaires générés par IA

Dans le paysage en évolution rapide du développement logiciel, le rôle de l’intelligence artificielle s’étend au-delà de la génération de code pour englober l’automatisation des tests. Au cours d’une période intensive de trois jours en février 2025, nous avons mené un projet de recherche approfondi chez DreamHost évaluant à quel point l’IA peut écrire de manière autonome des tests unitaires avec une intervention humaine minimale. Cet article partage les principales découvertes, métriques et perspectives qui pourraient redéfinir notre approche de l’automatisation des tests.

Le Principe de la Recherche

L’objectif principal était clair : évaluer si l’IA peut créer de manière fiable des tests unitaires de qualité de production sans aucune écriture de code humain. Ce n’était pas simplement un exercice académique — chez DreamHost, nous appliquons l’IA pour décupler par « 100000x » notre productivité dans le projet de Planificateur d’entreprise IA, et cette recherche était conçue pour repousser encore plus ces limites. Cette approche représente un changement significatif par rapport aux flux de travail de tests unitaires traditionnels et pourrait avoir un impact considérable sur la productivité du développement.

Paramètres du projet

Pour cette recherche, nous avons établi une méthodologie structurée :

- Entrée IA : Fournis à l’IA le code source, des fichiers d’essai exemples montrant les motifs/styles, les exigences de test, et le contexte de l’environnement de développement

- Limites Humaines : Limite l’input humain aux clarifications, à la correction des idées fausses, et à la fourniture du contexte manquant — sans écriture directe de code

- Concentration sur la Mesure : Suit le temps jusqu’à l’achèvement, les itérations nécessaires, les types d’erreurs rencontrées, la qualité de la sortie, la couverture atteinte, et l’effort humain requis

Nos critères de succès étaient ambitieux mais nécessaires pour l’applicabilité en production :

- Couverture des tests à 100%

- Implémentation sûre de type

- Adhésion aux meilleures pratiques de test

- Intervention humaine minimale

- Délai de réalisation raisonnable

- Code de test maintenable

Principales Découvertes de l’Étude

En seulement trois jours, notre équipe a ajouté 273 nouveaux tests au projet de Planificateur d’entreprise IA, augmentant considérablement notre couverture de test. Après avoir analysé plusieurs implémentations de test générées par IA à travers différents services et composants, plusieurs modèles ont émergé qui fournissent des aperçus précieux sur l’état actuel des tests unitaires pilotés par l’IA.

1. Mesures D’efficacité

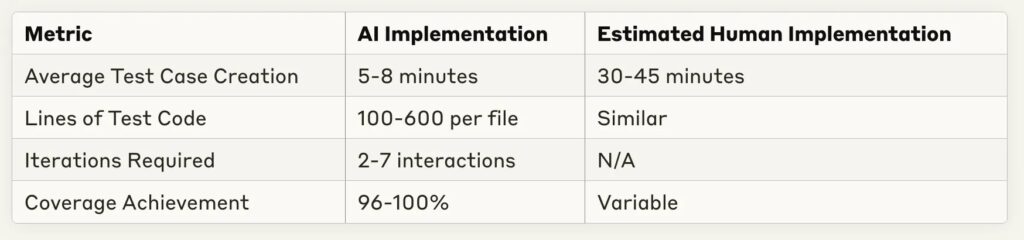

L’une des découvertes les plus frappantes a été la réduction spectaculaire du temps de mise en œuvre :

Les économies de temps sont substantielles — la plupart des implémentations de test ont été complétées en moins de 10 minutes, avec un équivalent humain estimé à 30–60 minutes pour la même tâche. Cela représente une augmentation potentielle de la productivité de 4 à 6 fois pour la rédaction de tests routiniers.

2. Les Forces Du Test IA

À travers plusieurs implémentations, certaines capacités IA se sont constamment démarquées :

- Couverture Complète : L’IA a constamment atteint une couverture de code de 96 à 100 % à travers différentes complexités de services

- Reconnaissance de Modèles : L’IA a excellé à reconnaître les modèles de tests à partir d’exemples et à les appliquer de manière constante

- Adaptation aux Retours : La plupart des erreurs pouvaient être résolues avec un minimum de clarifications

- Implémentation de Simulations : L’IA a démontré de solides capacités à créer des simulations et des dispositifs de test appropriés

- Consistance Structurelle : L’organisation des tests suivait les meilleures pratiques avec des modèles clairs de préparation-action-vérification

3. Limitations et Défis Observés

Malgré des résultats impressionnants, plusieurs défis récurrents sont apparus :

- Gestion des Types TypeScript : La source la plus fréquente d’erreurs était des définitions de types incomplètes ou des suppositions incorrectes concernant les types

- Compréhension de la Structure du Projet : Les chemins d’importation et les relations de dépendance nécessitaient souvent des corrections manuelles

- Couverture des Cas Limites : Bien que les chemins de base étaient bien couverts, la logique conditionnelle complexe nécessitait parfois des cas de test supplémentaires

- Hypothèses sur les Modèles : L’IA faisait parfois des hypothèses infondées sur des modèles ou des schémas spécifiques à l’application

- Exigences d’Itération : Les services plus complexes nécessitaient plus d’échanges pour atteindre une couverture complète

Instantanés D’étude De Cas

Examinons quelques implémentations représentatives pour mieux comprendre ces modèles.

Cas 1 : Test D’Exportation De Constante Simple

Pour tester des fichiers contenant principalement des exportations constantes :

- Durée de mise en œuvre : 1 minute 30 secondes

- Cas de test : 10

- Couverture : 100%

- Itérations : 1 (aucune correction nécessaire)

- Approche : Utilisation efficace des tests de snapshots pour les grands objets constants

Ce cas démontre que pour des scénarios de test simples, l’IA peut générer des tests complets sans aucune itération — essentiellement « parfait » dès la première tentative.

Cas 2 : Service Complexe avec Dépendances DI

Pour un service plus complexe avec injection de dépendances :

- Temps D’implémentation : 4 minutes 50 secondes

- Cas De Test : 5

- Couverture : 100%

- Itérations : 2

- Défis : L’implémentation du test Bootstrap nécessitait des corrections de liaison de dépendance

L’IA a réussi à traiter les tests d’injection de dépendances, nécessitant seulement de légères modifications pour l’initialisation du conteneur.

Cas 3 : Service Très Complexe Avec De Nombreuses Branches

Pour les services les plus complexes testés :

- Durée De Mise En Œuvre : 24 minutes

- Cas De Test : 11

- Couverture : 51.26% (en dessous de l’objectif)

- Itérations : 5–6

- Défis : Difficulté à atteindre une couverture complète des branches pour une logique conditionnelle complexe

Cela représente un cas limite important où l’IA a encore des difficultés avec les tests complets d’une logique de branchement très complexe.

Implications pour le Processus de Développement

Ces découvertes suggèrent plusieurs changements dans notre approche de la mise en œuvre des tests :

1. Flux de Travail Révisé

Plutôt que les développeurs rédigent des tests à partir de zéro, un workflow plus efficace semble être :

- Le développeur fournit le code source et les tests d’exemple à l’IA

- L’IA génère une première mise en œuvre des tests

- Le développeur fournit des retours itératifs sur des problèmes spécifiques

- L’IA affine la mise en œuvre jusqu’à atteindre les objectifs de couverture

- Le développeur effectue la revue finale et valide les modifications

Cette approche permet aux développeurs de se concentrer sur l’évaluation de la qualité des tests et des cas limites plutôt que sur la rédaction de code de test standard.

2. Opportunités D’Optimisation

Plusieurs pratiques ont considérablement amélioré la performance de génération de tests IA :

- Fournir des tests exemples clairs dans le même style/modèle

- Spécifier les exigences de couverture exactes dès le début

- Inclure des informations sur les types complexes

- Identifier proactivement les cas limites potentiels

- Utiliser des approches de test en premier lieu où l’IA a accès simultanément à l’implémentation et aux tests

3. Impact Économique

Basé sur la comparaison entre le temps d’implémentation de l’IA et le temps estimé d’implémentation humaine, les gains de productivité potentiels sont substantiels :

- Réduction de 70 à 85% du temps consacré à la rédaction de tests unitaires routiniers

- Meilleure cohérence de la couverture

- Cycles de retour d’information plus rapides pendant le développement

- Plus de cas de test pour le même effort de développement

Regard Vers L’Avenir : Le Futur Des Tests Pilotés Par IA

Cette recherche représente une première enquête sur ce qui deviendra probablement une pratique de développement standard. Plusieurs tendances suggèrent la direction de ce domaine :

Opportunités Futures

- Développement Dirigé par les Tests : L’IA pourrait générer à la fois des tests et du code d’implémentation de manière itérative

- Intégration avec CI/CD : Génération et maintenance automatisées des tests pendant le processus de construction

- Formation sur Domaine Personnalisé : Ajustement fin des modèles pour des bases de code ou des motifs spécifiques

- Tests Auto-Réparateurs : IA qui met à jour les tests lorsque l’implémentation change

- Modèles de Tests Spécialisés : Modèles d’IA spécifiquement optimisés pour la génération de tests

Défis Restants

Malgré des progrès significatifs, plusieurs défis subsistent :

- Gestion d’État Complexe : Tester des composants à état avec des interactions complexes

- Connaissances Spécialisées : Tests requérant des perspectives spécifiques au domaine ou des règles commerciales

- Tests d’Intégration : Aller au-delà des tests unitaires pour les tests d’intégration et systémiques

- Tests de Performance : Identifier et rédiger des tests de performance efficaces

- Tests de Sécurité : Trouver et exploiter les vulnérabilités de sécurité

Résumé Du Projet : Les Chiffres

Voici un aperçu de ce que nous avons accompli lors de notre expérience de trois jours :

- Ajout De Tests: 273 nouveaux tests ajoutés (de 22 à 295 au total)

- Taux De Réussite: ~90% des tentatives ont atteint avec succès une couverture de 100%

- Temps D’implémentation: Moyenne de 5–8 minutes par composant

- Plus Grande Suite De Tests: 273 tests ajoutés en environ 6 heures de temps de travail total

- Implémentation La Plus Rapide: 90 secondes pour les instantanés de framework avec une couverture de 100%

- Cas Le Plus Complexe: Composant graphique avec 13 dépendances, complété en 5 minutes

- Niveau De Qualité: Qualité de code maintenue au niveau d’un développeur senior

- Contribution Humaine: Zéro ligne de code écrite par des humains

D’un point de vue retour sur investissement, nous estimons une économie de temps de 70 à 80 % par rapport à une mise en œuvre manuelle, sans compromis sur la qualité. L’unique échec notable était avec le RunsService, où nous n’avons atteint que 51 % de couverture en raison d’une logique de branchement extrêmement complexe.

Conclusion : Recommandations Pratiques

Sur la base de cette recherche, nous recommandons les pratiques suivantes pour les équipes souhaitant exploiter l’IA pour les tests unitaires :

- Commencez Simple : Commence par des composants simples qui suivent des modèles établis

- Fournis Des Exemples : Inclus des exemples représentatifs de ton style de test

- Rétroaction Itérative : Prévois 2 à 3 cycles de rétroaction pour obtenir des résultats optimaux

- Concentre-Toi Sur Les Cas Limites : Utilise tes connaissances du domaine pour suggérer des cas limites que l’IA pourrait manquer

- Établis Des Directives Claires : Définis à quoi ressemble le « terminé » pour la couverture et le style des tests

- Mises À Jour Régulières : À mesure que les modèles d’IA s’améliorent, revisite ton approche pour tirer parti des nouvelles capacités

L’aspect le plus excitant de cette recherche est qu’il représente juste le début. À mesure que les capacités de l’IA continuent d’évoluer, le potentiel des tests pilotés par l’IA s’étendra à des domaines de tests plus complexes, transformant finalement la manière dont nous abordons l’assurance qualité dans le développement logiciel.

Cette recherche a été menée sur trois jours en février 2025 sur le projet de Planificateur d’entreprise de DreamHost, utilisant plusieurs modèles d’IA dont GitHub Copilot, les modèles GPT d’OpenAI, et Claude d’Anthropic. L’environnement de test était un service basé sur TypeScript avec Jest et ts-mockito pour les tests, se concentrant sur les composants d’application d’entreprise réels. Plus important encore, nous n’avons écrit aucune ligne de code durant tout le processus — toute l’implémentation des tests a été réalisée par l’IA avec seulement une supervision humaine.

Ce billet est la Partie 3 d’une série en 4 parties. Assure-toi de consulter les autres billets de la série pour une analyse plus approfondie de notre générateur de plans d’affaires piloté par IA.

Partie 1 : Comment nous avons construit un générateur de plans d’affaires piloté par IA utilisant LangGraph & LangChain

Partie 2 : Comment nous avons optimisé la génération de plans d’affaires IA : Compromis vitesse contre qualité

Partie 3 : Comment nous avons créé 273 tests unitaires en 3 jours sans écrire une seule ligne de code

Partie 4 : Cadre d’évaluation IA — Comment nous avons construit un système pour évaluer et améliorer les plans d’affaires générés par IA