Esta publicación es la Parte 4 de una serie de 4 partes. Asegúrate de revisar las otras publicaciones de la serie para un análisis más profundo sobre nuestro generador de planes de negocios impulsado por IA.

Parte 1: Cómo Construimos un Generador de Planes de Negocios Impulsado por IA Usando LangGraph & LangChain

Parte 2: Cómo Optimizamos la Generación de Planes de Negocios con IA: Velocidad vs. Compromisos de Calidad

Parte 3: Cómo Creamos 273 Pruebas Unitarias en 3 Días Sin Escribir ni una Sola Línea de Código

Parte 4: Marco de Evaluación de la IA — Cómo Construimos un Sistema para Evaluar y Mejorar los Planes de Negocios Generados por IA

Introducción: El Desafío de Evaluar Planes de Negocios con IA

Evaluar el contenido generado por IA de manera objetiva es complejo. A diferencia de las salidas estructuradas con respuestas claramente correctas o incorrectas, los planes de negocios involucran pensamiento estratégico, evaluaciones de viabilidad y coherencia, haciendo que la evaluación sea altamente subjetiva.

Esto planteó desafíos clave:

- ¿Cómo cuantificamos el contenido de un plan de negocios “bueno” vs. “malo”?

- ¿Cómo podemos asegurar que la IA se mejore por sí misma con el tiempo?

- ¿Cómo hacemos que la evaluación sea consistente e imparcial?

Para resolver esto, desarrollamos un marco de puntuación estructurado que nos permite evaluar, iterar y mejorar los planes de negocios generados por IA. Nuestro enfoque combinó varios marcos de evaluación, cada uno adaptado a diferentes secciones del plan, asegurando tanto la precisión como la profundidad estratégica.

Es importante señalar que este sistema de evaluación detallado fue parte de nuestra implementación original, donde cada sección pasó por una evaluación y iteración rigurosas. Sin embargo, debido a las limitaciones de rendimiento, nosotros simplificamos el proceso de evaluación en el MVP para priorizar la velocidad de generación. Este compromiso nos ayudó a desplegar más rápido mientras manteníamos el marco de evaluación como parte de la investigación continua para futuras mejoras.

Investigaciones recientes en Evaluación Basada en LLM han confirmado la efectividad de la evaluación AI estructurada. Estudios como Prometheus 2: Un Modelo de Lenguaje de Código Abierto Especializado en Evaluar Otros Modelos de Lenguaje (2024) y el framework Evals de OpenAI han demostrado que los LLMs pueden ser evaluadores confiables cuando son guiados por criterios de puntuación estructurados.

Diseñando el Marco de Evaluación

Nos inspiramos en los sistemas de calificación de profesores y lo aplicamos a los planes de negocios generados por IA. Esto llevó a la creación de varios marcos de evaluación, cada uno adaptado a diferentes tipos de secciones.

Marcos de Evaluación por Tipo de Sección

En lugar de usar un método de puntuación único para todos, hemos desarrollado criterios de puntuación personalizados dependiendo del tipo de contenido que se evalúa:

Planificación Estratégica & Modelo de Negocio

- Evaluado por claridad, alineación con objetivos SMART y factibilidad.

- Requiere planes de acción explícitos y establecimiento de objetivos estructurado.

Investigación de Mercado & Análisis Competitivo

- Enfocado en la profundidad de la investigación, diferenciación y validación de datos del mundo real.

- Las respuestas de IA fueron evaluadas basándose en el realismo de mercado y posicionamiento competitivo.

Planificación Financiera & Proyecciones

- Evaluación de supuestos financieros, modelado de ingresos y desglose de gastos.

- Las salidas de IA tuvieron que ser cuantificadas, internamente consistentes y razonables.

Estrategia Operativa y de Ejecución

- Calificado en viabilidad, mitigación de riesgos y hoja de ruta de ejecución.

- Requiere una estructura clara de equipo y asignación de recursos.

Estrategia de Marketing & Ventas

- Evaluado en función de la alineación con el público objetivo, el potencial de conversión y la consistencia de la marca.

- Los planes de marketing generados por IA debían ser específicos y basados en datos.

Cada Framework asignó pesos a diferentes dimensiones de puntuación, asegurando que las áreas críticas (por ejemplo, viabilidad financiera) influyeran más en la puntuación total que las menos críticas. Esto se alinea con hallazgos recientes de Prometheus 2: Un Modelo de Lenguaje de Código Abierto Especializado en Evaluar Otros Modelos de Lenguaje, que enfatizó la necesidad de referencias de evaluación detalladas usando LLMs.

Mecanismo de Puntuación de Evaluación

Cada sección fue puntuada de 1 a 5, siguiendo una rúbrica:

Mejora Iterativa Impulsada Por IA

Para permitir que la IA se automejore, hemos diseñado un bucle de retroalimentación de múltiples pasos:

Paso 1: Generación de Borrador

- La IA genera un borrador inicial basado en la entrada del usuario.

- Las secciones están estructuradas de acuerdo a plantillas predefinidas.

Paso 2: Autoevaluación de IA

- La IA revisa su propio resultado contra los marcos de evaluación específicos de la sección.

- Identifica áreas con datos faltantes, explicaciones vagas o una débil alineación estratégica.

Paso 3: Auto-Mejora de IA

- La IA regenera las secciones débiles, asegurando un mejor alineamiento con los criterios de evaluación.

- Si los análisis financieros o de mercado son insuficientes, la IA ajusta suposiciones y razonamientos.

Paso 4: Evaluación Final

- La IA realiza una segunda evaluación para validar sus propias mejoras.

- La versión final es comparada con iteraciones anteriores para seguir el progreso.

Este proceso iterativo de generar → evaluar → mejorar se alinea con investigaciones de vanguardia que muestran que las evaluaciones basadas en LLM mejoran a través de múltiples pasadas.

Validación Estadística: ¿Realmente Funcionó?

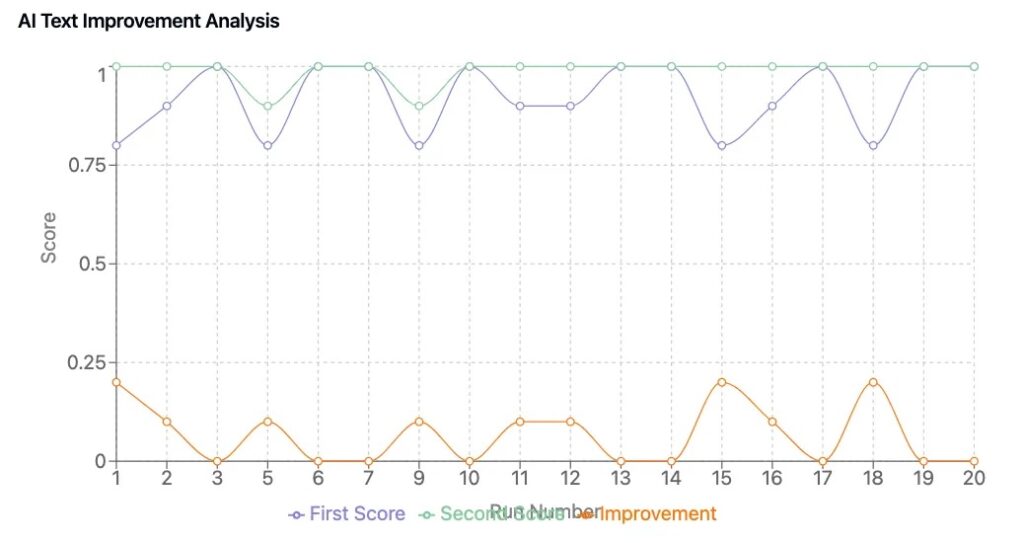

Para confirmar que nuestro Framework condujo a mejoras tangibles, realizamos un ciclo de prueba de 50 planes, comparando planes de negocios generados por IA con y sin bucles de auto-mejora.

Principales Hallazgos

- Consistencia en la Puntuación: El contenido generado por IA puntuó de manera consistente, reduciendo las fluctuaciones aleatorias en la calidad del plan.

- Mejora Medible: Los planes que se sometieron a refinamiento impulsado por IA mejoraron en 0.6 a 1.2 puntos en promedio.

- Mejores Perspectivas de Negocio: Las versiones refinadas tuvieron una alineación estratégica más fuerte, proyecciones financieras más claras y mensajes más persuasivos.

Estos hallazgos reflejan tendencias observadas en investigación de evaluación de LLM, donde los marcos de calificación estructurados y la puntuación iterativa mejoran significativamente el contenido generado por la IA.

Conclusiones Clave

1. La IA Puede Automejorarse Cuando Se Le Dan Criterios de Evaluación Estructurados

- Un marco de puntuación bien definido permite que la IA reconozca y corrija sus propias debilidades.

2. La Puntuación Cuantitativa Asegura la Validación Objetiva del Contenido

- Las evaluaciones subjetivas se minimizaron mediante rúbricas de calificación estandarizadas.

3. El Marco de Evaluación Fue Diseñado para Iteraciones de IA Avanzadas, pero el MVP Se Centró en la Velocidad

- La implementación original incluía múltiples ciclos de evaluación por sección.

- Debido a las limitaciones de rendimiento, simplificamos esto en el MVP pero lo mantuvimos para futuras investigaciones y mejoras.

4. Los Evaluadores LLM Son una Tendencia en Toda la Industria

- Nuevos modelos de evaluación de IA (por ejemplo, Prometheus 2: Un Modelo de Lenguaje de Código Abierto Especializado en la Evaluación de Otros Modelos de Lenguaje, LLMs-como-Jueces) están mejorando la consistencia y reduciendo el sesgo. (arxiv.org)

- El campo de evaluación de IA está evolucionando hacia marcos de puntuación multicapa, validando el enfoque que nosotros pioneros.

Prueba Nuestra Suite de Negocios con IA

Nosotros construimos y optimizamos nuestro generador de planes de negocios impulsado por IA en DreamHost, asegurando un rendimiento y escalabilidad a nivel empresarial.

Los clientes de DreamHost pueden hacer clic aquí para comenzar y explorar nuestro generador de planes de negocios impulsado por IA y otras herramientas de IA.

Esta publicación es la Parte 4 de una serie de 4 partes. Asegúrate de revisar las otras publicaciones de la serie para profundizar en nuestro generador de planes de negocio impulsado por IA.

Parte 1: Cómo Construimos un Generador de Planes de Negocio Impulsado por IA Usando LangGraph & LangChain

Parte 2: Cómo Optimizamos la Generación de Planes de Negocio con IA: Velocidad vs. Calidad en las Decisiones

Parte 3: Cómo Creamos 273 Pruebas de Unidad en 3 Días Sin Escribir una Sola Línea de Código

Parte 4: Marco de Evaluación de IA — Cómo Construimos un Sistema para Puntuar y Mejorar Planes de Negocio Generados por IA