Dieser Beitrag ist Teil 1 einer vierteiligen Serie. Stelle sicher, dass Du die anderen Beiträge der Serie ansiehst, um tiefer in unseren AI-gesteuerten Geschäftsplanersteller einzutauchen.

Teil 1: Wie wir einen AI-gesteuerten Geschäftsplanersteller mit LangGraph & LangChain entwickelt haben

Teil 2: Wie wir die AI-Geschäftsplangenerierung optimiert haben: Geschwindigkeit vs. Qualitäts-Kompromisse

Teil 3: Wie wir in 3 Tagen 273 Unit-Tests erstellt haben, ohne eine einzige Zeile Code zu schreiben

Teil 4: AI-Bewertungsframework – Wie wir ein System entwickelt haben, um AI-erstellte Geschäftspläne zu bewerten und zu verbessern

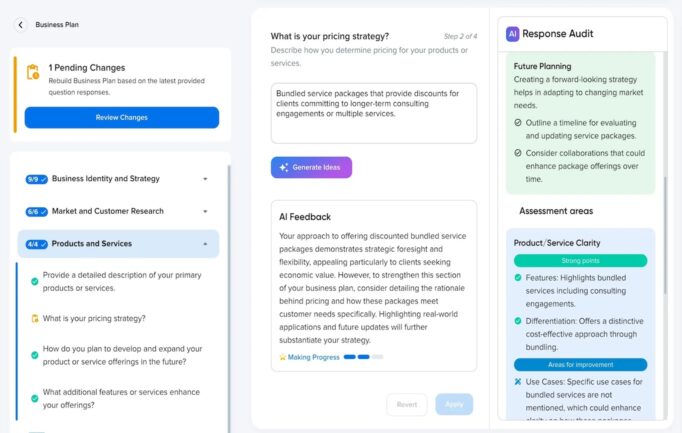

Beim Aufbau eines KI-gestützten Geschäftsplan-Generators haben wir von Grund auf mit LangChain und LangGraph begonnen, da wir ein agentisches Framework benötigten, das komplexe Workflows handhaben kann. Im Gegensatz zu unserem vorherigen Projekt, dem Business Advisor — einem Chat-basierten Agenten, der auf OpenAI’s SDK und pipeline-basierter Verarbeitung beruhte — erforderte dieses neue Projekt einen strukturierten, mehrstufigen KI-Workflow, um Geschäftspläne dynamisch zu generieren und zu verfeinern.

Unser Produktteam hat die Kernfunktionalität wie folgt definiert:

- Benutzer würden ein Geschäftsinterview durchführen, bei dem sie strukturierte Fragen beantworteten.

- Jedes Frage-Antwort-Paar würde spezifischen Abschnitten im Geschäftsplan zugeordnet.

- Benutzer könnten später Antworten aktualisieren, was eine Regenerierung der betroffenen Abschnitte auslösen würde.

- Das System war darauf ausgelegt, zukünftige domänenspezifische Agenten zu unterstützen, wie etwa Spezialisten für Finanzmodellierung oder Marktforschung.

Angesichts des zunehmenden Trends von Multi-Agenten-AI-Workflows in Geschäftsanwendungen haben wir unser System mit modularen, skalierbaren AI-Komponenten strukturiert, die effizient zusammenarbeiten können, während sie Genauigkeit, Konsistenz und Anpassungsfähigkeit sicherstellen.

Warum Wir Uns Für LangChain & LangGraph Entschieden Haben

Der Aufbau einer komplexen, von KI angetriebenen Anwendung erforderte mehr als nur einfache LLM-Abfragen. Wir benötigten:

- Modellunabhängige Architektur: Die Fähigkeit, zwischen OpenAI-Modellen, Claude und sogar lokalen LLMs ohne große Umschreibungen zu wechseln.

- Graphbasierte Ausführung: Eine Möglichkeit, Arbeitsabläufe dynamisch zu strukturieren und starre Pipelines zu vermeiden.

- Zustandsspeicher: Die Fähigkeit des Systems, Zwischenergebnisse über Schritte hinweg zu behalten.

- Skalierbarkeit: Die Flexibilität, in Zukunft mehr spezialisierte KI-Agenten hinzuzufügen.

LangChain und LangGraph ermöglichten diese Fähigkeiten durch gerichtete azyklische Graphen (DAG)-basierte Workflows, die komplexe Interaktionen zwischen mehreren Verarbeitungsknoten ermöglichen.

Obwohl wir nicht sofort domänenspezifische Agenten implementiert haben, haben wir das System so entworfen, dass es zukünftige KI-Modelle unterstützt, die sich auf finanzielle Prognosen, rechtliche Konformität oder Marktanalyse spezialisieren, um sicherzustellen, dass das Framework flexibel bleibt.

Ein Haupttrend, den wir identifiziert haben, war die zunehmende Einführung von Multi-Agenten-KI-Workflows in komplexen Geschäftsanwendungen. Unternehmen wie LinkedIn und Uber haben erfolgreich agentenbasierte Architekturen eingesetzt, um Betrieb und Entscheidungsfindung zu verbessern. Inspiriert davon haben wir unser System so gestaltet, dass mehrere KI-Knoten dynamisch zusammenarbeiten können, um sicherzustellen, dass jeder Verarbeitungsschritt unabhängig optimiert werden kann, während eine nahtlose Integration aufrechterhalten wird.

Implementierung des AI-Workflows

Die Kernarchitektur bestand aus:

- Nutzerantworten aus dem Interview als strukturierte Daten gespeichert.

- LangGraph-basierter Workflow der Aufgaben dynamisch an relevante KI-Knoten weiterleitete.

- Eine hybride Modellauswahlstrategie, die es ermöglichte, verschiedene Aufgaben von unterschiedlichen OpenAI-Modellen bearbeiten zu lassen (GPT-4o für detaillierte Abschnitte, GPT-4o-mini für allgemeine Entwürfe).

- Ein hybrider Generierungsansatz, bei dem einige Abschnitte individuell für Genauigkeit generiert wurden, während andere in Blöcken für Effizienz verarbeitet wurden.

Schritt-Für-Schritt Zerlegung Der Abläufe

Unser Workflow zur Erstellung von Geschäftsplänen umfasste mehrere aufeinanderfolgende Schritte:

- Entwurfsknoten — Generiert einen ersten Entwurf des Geschäftsplans basierend auf Benutzerantworten.

- Bewertungsknoten — Bewertet den Entwurf, identifiziert Lücken und Verbesserungsbereiche.

- Nachbewertungs-Verfeinerung — Passt den Entwurf basierend auf dem Bewertungsfeedback an.

- Endgültige Erstellung — Erstellt die finale Version, die Vollständigkeit und Kohärenz sicherstellt.

Dieser mehrstufige Ansatz gewährleistete eine progressive Verfeinerung des Geschäftsplans, anstatt sich auf einen einzelnen Durchlauf der KI-Generierung zu verlassen. Aufgrund von Leistungsbeschränkungen haben wir dies jedoch später zu einem einstufigen Generierungsprozess vereinfacht aus Gründen der Benutzerfreundlichkeit, worüber wir in einem zukünftigen Artikel diskutieren werden.

Beispiel Für Graphbasierte Verarbeitung

graph TD;

A[Nutzerinterview] --> B[Entwurfserstellung];

B --> C[Bewertung];

C --> D[Nachbewertungsverfeinerung];

D --> E[Endgültiger Geschäftsplan];

Diese Struktur veranschaulicht, wie Aufgaben durch verschiedene Stufen fließen und so eine modulare und skalierbare Ausführung gewährleistet wird.

Beispiel: Verwendung Von Tool-Aufrufen Für Strukturierte Erzeugung

Eine unserer wichtigsten Entscheidungen war es, das Tool Calling im strengen Modus von OpenAI zu nutzen. Dies ermöglichte es den KI-Modellen, mit strukturierten Funktionen zu interagieren und vorhersehbare, formatierte Antworten zu erzwingen, wodurch Halluzinationen reduziert wurden.

Beispiel Für Toolaufruf: Erstellen Von Geschäftsplanabschnitten

import { StructuredToolWithStrict } from 'langchain/tools';

import { z } from 'zod';

const sectionsSchema = z.object({

sections: z.array(

z.object({

id: z.string().describe('Die ID des Abschnitts'),

slug: z.string().describe('Der Template-Slug für diesen Abschnitt'),

content: z.string().describe('Der generierte Inhalt für diesen Abschnitt')

})

).describe('Eine Reihe von Abschnitten des Geschäftsplans')

}).strict();

export class GenerateBusinessPlanSections extends StructuredToolWithStrict {

name = 'generate_sections';

description = 'Erzeugt strukturierte Abschnitte des Geschäftsplans basierend auf Benutzereingaben.';

schema = sectionsSchema;

async _call(input) {

return { sections: input.sections }; // AI-generierter Inhalt, bereitgestellt als Tool-Argumente

}

}

Die Verwendung von Zod zur Schemavalidierung stellte sicher, dass die Antworten immer wohlgeformt und typsicher waren, wodurch Parsierfehler reduziert und eine automatisierte Validierung von AI-generierten Inhalten ermöglicht wurde.

Herausforderungen & LangChain-Änderungen

Trotz der Vorteile von LangChain und LangGraph stießen wir auf mehrere Hindernisse, die benutzerdefinierte Anpassungen erforderten:

- LangChain-Einschränkungen → Fehlender strenger Modus für Tool-Aufrufe und mangelnde Unterstützung für das Streaming von Tool-Ausgaben. Wir haben LangChains eingebaute Funktionen erweitert, um strengere Ausgabebedingungen durchzusetzen und LangGraph modifiziert, um das inkrementelle Streaming von strukturierten Antworten zu ermöglichen.

- Mangelhafte LangChain-Dokumentation → Wir mussten häufig den Quellcode von LangChain lesen und analysieren, da die Dokumentation unzureichend war, was die Implementierung verlangsamte und das Debugging erschwerte.

- Probleme mit der Codequalität → Bestimmte Bereiche der LangChain-Implementierung waren wartungsintensiv, was uns dazu veranlasste, Schlüsselkomponenten zu überarbeiten und zu optimieren.

- Performance-Engpässe mit OpenAI’s Assistants API → Anfangs verwendeten wir die Assistants API, stellten jedoch fest, dass die Thread-Erzeugung erhebliche Latenz verursachte und zusätzliche unstrukturierte Nachrichten in Tool-Aufrufen die Antwortzeiten verlangsamten. Letztendlich wechselten wir zur Chat API für strukturierte Antworten und verbesserten die Effizienz.

Um diese zu adressieren, haben wir eine spezielle OpenAIAssistantRunnable entwickelt, eine spezialisierte Komponente basierend auf der bestehenden Implementierung von LangChain, jedoch erweitert um Streaming, strikte Toolaufrufe und mehrstufige Workflows zu unterstützen.

Endgültige Architekturanpassung

Obwohl die ursprüngliche Architektur der Operationen intakt blieb, haben wir die Anzahl der Verarbeitungsschritte von mehreren Iterationen zu einer Einzelschrittgenerierung reduziert, um die Geschwindigkeit und Benutzererfahrung in der endgültigen Version zu verbessern.

Wichtige Erkenntnisse

- LangChain + LangGraph waren unerlässlich aber erforderten tiefgreifende Anpassungen für strukturierte Antworten und Werkzeugaufrufe.

- Hybride Generierungsansätze — die Kombination von Einzel- und Stapelverarbeitung — ermöglichten es uns, Genauigkeit und Effizienz auszubalancieren.

- Strukturierte Antworten und Schema-Validierung verbesserten die Qualität und Zuverlässigkeit der KI-Ausgabe erheblich.

- Ein mehrstufiger Verarbeitungsansatz wurde anfangs verwendet, aber aufgrund von Leistungseinschränkungen wurde eine vereinfachte einstufige Generierung implementiert.

- Optimierung der KI-Ausführungsgeschwindigkeit durch den Wechsel von der Assistants-API zur Chat-API reduzierte drastisch die Generierungszeit, während strukturierte Antworten erhalten blieben.

Probiere Unser AI-gesteuertes Business-Suite Aus

Erlebe die vollen Fähigkeiten unserer von KI angetriebenen Geschäftstools, die auf DreamHost aufgebaut und gehostet sind. Von der Geschäftsplanung bis zur Inhaltsproduktion, unsere Suite von KI-Tools ist darauf ausgelegt, Unternehmern und Unternehmen zu helfen, ihre Abläufe zu optimieren.

DreamHost-Kunden können hier klicken, um zu beginnen und unseren AI-gesteuerten Geschäftsplan-Generator und andere AI-Tools zu erkunden.

Dieser Beitrag ist Teil 1 einer vierteiligen Serie. Schau Dir unbedingt die anderen Beiträge der Serie an, um einen tieferen Einblick in unseren mit KI betriebenen Geschäftsplan-Generator zu erhalten.

Teil 1: Wie wir einen KI-betriebenen Geschäftsplan-Generator mit LangGraph & LangChain entwickelt haben

Teil 2: Wie wir die Erstellung von KI-Geschäftsplänen optimiert haben: Geschwindigkeit gegenüber Qualitätsabwägungen

Teil 3: Wie wir in 3 Tagen 273 Unit-Tests erstellt haben, ohne eine einzige Zeile Code zu schreiben

Teil 4: KI-Bewertungsframework – Wie wir ein System entwickelt haben, um KI-erzeugte Geschäftspläne zu bewerten und zu verbessern