Dieser Beitrag ist Teil 3 einer vierteiligen Serie. Stelle sicher, dass Du die anderen Beiträge der Serie ansiehst, um tiefer in unseren KI-gesteuerten Geschäftsplan-Generator einzutauchen.

Teil 1: Wie wir einen KI-gesteuerten Geschäftsplan-Generator mit LangGraph & LangChain entwickelt haben

Teil 2: Wie wir die KI-Geschäftsplangenerierung optimiert haben: Geschwindigkeit vs. Qualitätskompromisse

Teil 3: Wie wir in 3 Tagen 273 Einheitentests erstellt haben, ohne eine einzige Zeile Code zu schreiben

Teil 4: KI-Bewertungsframework – Wie wir ein System zur Bewertung und Verbesserung von KI-erzeugten Geschäftsplänen entwickelt haben

In der sich schnell entwickelnden Landschaft der Softwareentwicklung erweitert sich die Rolle der künstlichen Intelligenz über die Codeerzeugung hinaus zur Automatisierung des Testens. Über einen intensiven Zeitraum von drei Tagen im Februar 2025 führten wir bei DreamHost ein tiefgehendes Forschungsprojekt durch, um zu bewerten, wie effektiv KI eigenständig Unit-Tests mit minimaler menschlicher Intervention schreiben kann. Dieser Artikel teilt wichtige Erkenntnisse, Metriken und Einsichten, die möglicherweise die Art und Weise, wie wir die Testautomatisierung angehen, verändern könnten.

Die Forschungsprämisse

Das Hauptziel war klar: zu bewerten, ob KI zuverlässig produktionsreife Unit-Tests erstellen kann, ohne dass Menschen Code schreiben müssen. Das war keine rein akademische Übung — bei DreamHost wenden wir KI an, um unsere Produktivität im Business Planner-Projekt „100000x“ zu steigern, und diese Forschung war darauf ausgelegt, diese Grenzen weiter zu verschieben. Dieser Ansatz stellt eine bedeutende Abkehr von traditionellen Unit-Testing-Workflows dar und könnte die Produktivität in der Entwicklung dramatisch beeinflussen.

Projektparameter

Für diese Forschung haben wir eine strukturierte Methodik festgelegt:

- AI-Eingabe: Gib der AI den Quellcode, Beispieltestdateien, die Muster/Stil zeigen, Testanforderungen und Kontext der Entwicklungsumgebung

- Menschliche Grenzen: Beschränke menschliche Eingaben auf Klarstellungen, Korrektur von Missverständnissen und Bereitstellung fehlender Kontexte — ohne direktes Codieren

- Messungsschwerpunkt: Verfolge die Zeit bis zur Fertigstellung, benötigte Iterationen, Arten von Fehlern, Ausgabequalität, erreichte Abdeckung und erforderlichen menschlichen Aufwand

Unsere Erfolgskriterien waren ehrgeizig, aber notwendig für die Produktionsanwendbarkeit:

- 100% Testabdeckung

- Typsichere Implementierung

- Einhaltung der besten Testpraktiken

- Minimale menschliche Intervention

- Vernünftige Fertigstellungszeit

- Wartbarer Testcode

Wichtige Forschungsergebnisse

In nur drei Tagen hat unser Team 273 neue Tests zum Business Planner-Projekt hinzugefügt, was unsere Testabdeckung erheblich erhöht hat. Nach der Analyse mehrerer von KI generierter Testimplementierungen über verschiedene Dienste und Komponenten hinweg sind mehrere Muster aufgetreten, die wertvolle Einblicke in den aktuellen Zustand der KI-gesteuerten Unit-Tests liefern.

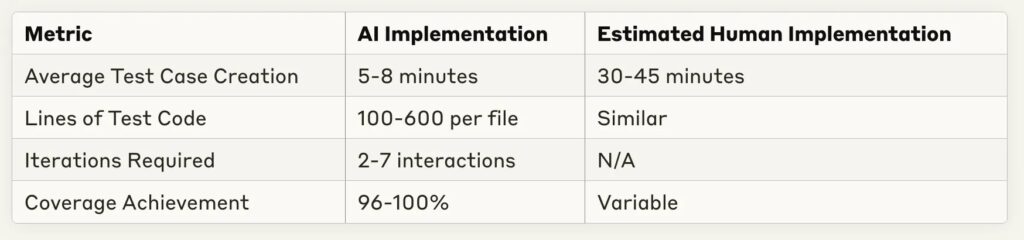

1. Effizienzkennzahlen

Einer der bemerkenswertesten Befunde war die drastische Reduzierung der Implementierungszeit:

Die Zeitersparnis ist erheblich — die meisten Testimplementierungen wurden in unter 10 Minuten abgeschlossen, was einer geschätzten menschlichen Entsprechung von 30–60 Minuten für dieselbe Aufgabe entspricht. Dies stellt eine potenzielle Produktivitätssteigerung von 4–6x für das routinemäßige Schreiben von Tests dar.

2. Stärken Des KI-Tests

Durch mehrere Implementierungen haben sich bestimmte KI-Fähigkeiten konsequent hervorgetan:

- Umfassende Abdeckung: AI erreichte konstant eine Codeabdeckung von 96–100% über verschiedene Dienstkomplexitäten hinweg

- Mustererkennung: AI zeichnete sich durch das Erkennen von Testmustern aus Beispielen aus und wendete diese konsequent an

- Anpassung an Rückmeldungen: Die meisten Fehler konnten mit minimaler Klärung behoben werden

- Mock-Implementierung: AI demonstrierte starke Fähigkeiten bei der Erstellung geeigneter Mocks und Testvorrichtungen

- Strukturkonsistenz: Die Organisation der Tests folgte den besten Praktiken mit klaren Arrange-Act-Assert-Mustern

3. Beobachtete Einschränkungen Und Herausforderungen

Trotz beeindruckender Ergebnisse traten mehrere wiederkehrende Herausforderungen auf:

- TypeScript Typenbehandlung: Die häufigste Fehlerquelle war unvollständige Typendefinitionen oder falsche Annahmen über Typen

- Verständnis der Projektstruktur: Importpfade und Abhängigkeitsbeziehungen erforderten oft eine menschliche Korrektur

- Abdeckung von Randfällen: Während einfache Pfade gut abgedeckt waren, benötigte komplexe bedingte Logik manchmal zusätzliche Testfälle

- Annahmen zu Vorlagen: Die KI machte gelegentlich unbegründete Annahmen über anwendungsspezifische Vorlagen oder Muster

- Anforderungen an Iterationen: Komplexere Dienste erforderten mehr Hin- und Her-Wechsel, um eine vollständige Abdeckung zu erreichen

Fallstudien-Schnappschüsse

Lass uns einige repräsentative Implementierungen untersuchen, um diese Muster besser zu verstehen.

Fall 1: Einfache Konstanten-Export-Tests

Zum Testen von Dateien, die hauptsächlich konstante Exporte enthalten:

- Implementierungszeit: 1 Minute 30 Sekunden

- Testfälle: 10

- Abdeckung: 100%

- Iterationen: 1 (keine Korrekturen erforderlich)

- Vorgehensweise: Effektive Verwendung von Snapshot-Tests für große konstante Objekte

Dieser Fall zeigt, dass AI bei einfachen Testszenarien vollständige Tests ohne Wiederholung erstellen kann — im Grunde genommen beim ersten Versuch „perfekt“.

Fall 2: Komplexer Dienst mit DI-Abhängigkeiten

Für einen komplexeren Service mit Abhängigkeitsinjektion:

- Implementierungszeit: 4 Minuten 50 Sekunden

- Testfälle: 5

- Abdeckung: 100%

- Iterationen: 2

- Herausforderungen: Bootstrap-Testimplementierung erforderte Bindungskorrekturen von Abhängigkeiten

Die KI hat das Dependency Injection Testing erfolgreich behandelt, wobei nur geringfügige Anpassungen für die Containerinitialisierung erforderlich waren.

Fall 3: Hochkomplexer Dienst Mit Vielen Zweigen

Für die getesteten komplexesten Dienste:

- Implementierungszeit: 24 Minuten

- Testfälle: 11

- Abdeckung: 51,26% (unter dem Ziel)

- Iterationen: 5–6

- Herausforderungen: Schwierigkeiten, volle Verzweigungsabdeckung bei komplexer bedingter Logik zu erreichen

Dies stellt einen wichtigen Grenzfall dar, bei dem KI immer noch mit umfassenden Tests sehr komplexer verzweigter Logik zu kämpfen hatte.

Auswirkungen Auf Den Entwicklungsprozess

Diese Ergebnisse deuten auf mehrere Veränderungen hin, wie wir die Testimplementierung angehen könnten:

1. Überarbeiteter Arbeitsablauf

Anstatt dass Entwickler Tests von Grund auf neu schreiben, scheint ein effizienterer Arbeitsablauf zu sein:

- Entwickler stellt Quellcode und Beispieltests für die KI bereit

- KI erstellt eine erste Testimplementierung

- Entwickler gibt iteratives Feedback zu spezifischen Problemen

- KI verfeinert die Implementierung, bis die Abdeckungsziele erreicht sind

- Entwickler führt die abschließende Überprüfung durch und führt Commits aus

Dieser Ansatz ermöglicht es Entwicklern, sich auf die Überprüfung der Testqualität und Grenzfälle zu konzentrieren, anstatt Boilerplate-Testcode zu schreiben.

2. Optimierungsmöglichkeiten

Mehrere Praktiken haben die Leistung der KI-Testgenerierung erheblich verbessert:

- Klare Beispieltests im gleichen Stil/Muster bereitstellen

- Genau festlegen der Abdeckungsanforderungen im Voraus

- Informationen über komplexe Typen einbeziehen

- Mögliche Randfälle proaktiv identifizieren

- Test-First-Ansätze verwenden, bei denen die KI gleichzeitig Zugriff auf Implementierung und Tests hat

3. Ökonomische Auswirkungen

Basierend auf dem Vergleich zwischen der Implementierungszeit von KI und der geschätzten Implementierungszeit des Menschen sind die potenziellen Produktivitätsgewinne erheblich:

- 70–85% Reduzierung der für das Schreiben routinemäßiger Unit-Tests aufgewendeten Zeit

- Höhere Abdeckungskonsistenz

- Schnellere Feedbackzyklen während der Entwicklung

- Mehr Testfälle bei gleichem Entwicklungsaufwand

Ausblick: Die Zukunft Des KI-Gesteuerten Testens

Diese Untersuchung stellt eine frühe Erforschung dar, die wahrscheinlich zu einer Standard-Entwicklungspraxis wird. Mehrere Trends deuten darauf hin, wohin sich dieses Feld entwickelt:

Zukünftige Möglichkeiten

- Testgetriebene Entwicklung: KI könnte iterativ sowohl Tests als auch Implementierungscode generieren

- Integration mit CI/CD: Automatisierte Testgenerierung und -wartung während des Build-Prozesses

- Training für Benutzerdefinierte Domains: Feinabstimmung von Modellen für spezifische Codebasen oder Muster

- Selbstheilende Tests: KI, die Tests aktualisiert, wenn sich die Implementierung ändert

- Spezialisierte Testmodelle: KI-Modelle, die speziell für die Testgenerierung optimiert sind

Verbleibende Herausforderungen

Trotz erheblicher Fortschritte bleiben einige Herausforderungen bestehen:

- Komplexes Zustandsmanagement: Testen von zustandsbehafteten Komponenten mit komplexen Interaktionen

- Spezialisiertes Wissen: Tests, die domänenspezifische Einsichten oder Geschäftsregeln erfordern

- Integrationstests: Über einfache Einheitentests hinausgehen zu Integration- und Systemtests

- Leistungstests: Identifizieren und Schreiben effektiver Leistungstests

- Sicherheitstests: Finden und Ausnutzen von Sicherheitslücken

Projektzusammenfassung: Die Zahlen

Hier ist ein Überblick darüber, was wir in unserem dreitägigen Experiment erreicht haben:

- Testzusätze: 273 neue Tests hinzugefügt (von 22 auf insgesamt 295)

- Erfolgsrate: ~90% der Versuche erreichten erfolgreich 100% Abdeckung

- Implementierungszeit: Durchschnittlich 5–8 Minuten pro Komponente

- Größte Testsuite: 273 Tests in ungefähr 6 Stunden Gesamtarbeitszeit hinzugefügt

- Schnellste Implementierung: 90 Sekunden für Framework-Snapshots mit 100% Abdeckung

- Komplexester Fall: Graph-Komponente mit 13 Abhängigkeiten, abgeschlossen in 5 Minuten

- Qualitätsniveau: Senior-Entwickler-Niveau der Codequalität beibehalten

- Menschlicher Input: Null Zeilen Code von Menschen geschrieben

Aus der Sicht der Kapitalrendite schätzen wir eine Zeitersparnis von 70–80% im Vergleich zur manuellen Implementierung, ohne Kompromisse bei der Qualität. Der einzige bemerkenswerte Misserfolg war beim RunsService, wo wir aufgrund extrem komplexer Verzweigungslogik nur eine Abdeckung von 51% erreichten.

Fazit: Praktische Empfehlungen

Basierend auf dieser Forschung empfehlen wir die folgenden Praktiken für Teams, die KI für das Unit-Testing nutzen möchten:

- Starte Einfach: Beginne mit einfachen Komponenten, die etablierten Mustern folgen

- Gebe Beispiele: Füge repräsentative Beispiele deines Teststils hinzu

- Iteratives Feedback: Plane 2–3 Feedback-Zyklen für optimale Ergebnisse

- Fokussiere auf Randfälle: Nutze dein Fachwissen, um Randfälle vorzuschlagen, die die KI verpassen könnte

- Erstelle Klare Richtlinien: Definiere, wie „fertig“ für Testabdeckung und Stil aussieht

- Regelmäßige Updates: Besuche deinen Ansatz neu, wenn sich KI-Modelle verbessern, um neue Fähigkeiten zu nutzen

Der spannendste Aspekt dieser Forschung ist, dass sie nur den Anfang darstellt. Da die Fähigkeiten von AI weiterhin fortschreiten, wird sich das Potenzial für AI-gesteuerte Tests auf komplexere Testbereiche ausdehnen und letztendlich verändern, wie wir die Qualitätssicherung in der Softwareentwicklung angehen.

Diese Forschung wurde über drei Tage im Februar 2025 am DreamHost Business Planner Projekt durchgeführt, unter der Verwendung mehrerer KI-Modelle einschließlich GitHub Copilot, OpenAI’s GPT-Modelle und Anthropic’s Claude. Die Testumgebung war ein auf TypeScript basierender Dienst mit Jest und ts-mockito für das Testen, fokussiert auf Komponenten von realen Unternehmensanwendungen. Am wichtigsten ist, dass wir während des gesamten Prozesses null Zeilen Code geschrieben haben — alle Testimplementierungen wurden von KI mit nur menschlicher Anleitung durchgeführt.

Dieser Beitrag ist Teil 3 einer vierteiligen Serie. Stelle sicher, dass Du auch die anderen Beiträge der Serie ansiehst, um einen tieferen Einblick in unseren AI-gesteuerten Geschäftsplan-Generator zu erhalten.

Teil 1: Wie wir einen AI-gesteuerten Geschäftsplan-Generator mit LangGraph & LangChain entwickelt haben

Teil 2: Wie wir die Generierung von AI-Geschäftsplänen optimiert haben: Geschwindigkeit gegenüber Qualitäts-Kompromisse

Teil 3: Wie wir in 3 Tagen 273 Unit-Tests erstellt haben, ohne eine einzige Zeile Code zu schreiben

Teil 4: AI-Bewertungsrahmen – Wie wir ein System entwickelt haben, um AI-erzeugte Geschäftspläne zu bewerten und zu verbessern